Die Begeisterung für ChatGPT hat in den letzten Monaten beispiellose Ausmaße erreicht und zählt zu den größten technologischen Hypes unserer Zeit.

Als revolutionärer Chatbot ermöglicht ChatGPT erstmals die einfache Kommunikation mit einer künstlichen Intelligenz und die beeindruckende Zahl von 100 Millionen Nutzer:innen innerhalb der ersten zwei Monate nach Veröffentlichung durch OpenAI spricht für sich.

Dennoch bringt dieser Erfolg auch eine Flut an Fehlinformationen und unsinnigen Aussagen mit sich.

Bei der Betrachtung von Blogs, Twitter, LinkedIn und den zahlreichen Prompt-Communities, auf denen die scheinbar besten Tipps und Tricks rund um ChatGPT ausgetauscht werden, wird klar, dass der Hype um die Technologie viele in seinen Bann zieht. Jeder möchte der Erste sein, der einen neuen Tipp teilt, wodurch sogar die abwegigsten Ratschläge rasend schnell Verbreitung finden.

Während der Recherche für mein aktuelles Sachbuch über ChatGPT, GPT-4 & Co. bin ich auf zahlreiche populäre Missverständnisse und Fehlannahmen gestoßen, denen ich in diesem Artikel den Kampf ansagen möchte:

Um Dich vor diesen Fehlinformationen zu schützen, werde ich die größten Missverständnisse rund um ChatGPT aufdecken und erklären. Einige sind vielleicht nur kleine Ungenauigkeiten, aber andere basieren auf so grundlegend falschen Annahmen, dass sie den Umgang mit der künstlichen Intelligenz tatsächlich gefährlich machen können!

Mein Ziel ist es nicht, jemanden bloßzustellen oder an den Pranger zu stellen. Daher verzichte ich zum Teil auf die Nennung der Quelle und habe Namen in den Screenshots unkenntlich gemacht. Es geht mir darum aufzuzeigen, wie vorschnell und unkritisch Informationen oder Prompts zu ChatGPT verbreitet werden, ohne ein grundlegendes Verständnis für die Funktionsweise von GPT zu haben.

1. Fehler: Falscher Umgang mit Bezeichnungen und Begriffen

Ein weitverbreiteter Fehler ist die Verwechslung von ChatGPT mit den zugrunde liegenden großen Sprachmodellen. Manchmal wird sogar von ChatGPT-4 gesprochen, obwohl es diese Bezeichnung gar nicht gibt.

Falsche Verwendung von „ChatGPT-4“ in einem ChatGPT-Guide

Tatsächlich ist ChatGPT der von OpenAI entwickelte Chatbot, der über die Webseite https://chat.openai.com/ erreichbar ist. GPT-3, GPT-3.5 und GPT-4 hingegen sind die großen Sprachmodelle von OpenAI, die über sogenannte APIs (Programmierschnittstellen) genutzt werden können.

Diese Modelle bilden die Basis für ChatGPT und viele andere kommerzielle KI-Text-Tools wie Jasper, Frase und Neuroflash. Als zahlende:r Nutzer:in von ChatGPT PLUS kann man innerhalb des Chatbots zwischen GPT-3.5 und dem neueren GPT-4 wählen, was vermutlich zur irreführenden Bezeichnung ChatGPT-4 geführt hat.

Obwohl dies auf den ersten Blick nur eine Ungenauigkeit zu sein scheint, deutet ein solcher Fehler darauf hin, dass der Autor oder die Autorin sich nicht ausreichend mit der Technologie auseinandergesetzt hat.

Daher ist Vorsicht geboten, wenn solche Informationen und Tipps geteilt werden. Zum Teil wird sogar der Begriff „Prompt“, der für die Anweisung an eine KI steht, mit der Antwort bzw. der Ausgabe der KI verwechselt:

Im Vergleich dazu erscheint der Fehler, statt von „Token“ bei der Längenbegrenzung der KI einfach von Wörtern zu sprechen, fast harmlos:

Hier wird statt von Tokens einfach von Wörtern gesprochen

Ein Token bezieht sich auf eine Texteinheit, die von der KI als separate Einheit verarbeitet wird. Ein Token kann ein Wort, eine Zahl, ein Satzzeichen, ein Symbol oder auch nur ein Teil eines Wortes sein.

Eine Faustregel besagt, dass ein Token im Durchschnitt etwa ¾ eines englischen Wortes entspricht. In einem englischen Text entsprächen 100 Token also etwa 75 Wörtern. Deutsche Wörter enthalten jedoch im Durchschnitt mehr Token, sodass ein deutscher Text mit 100 Token möglicherweise nur 50 Worte umfasst.

Ein besonders kurioses Beispiel findet sich im selben „ChatGPT Guide“, den ich in den vorherigen Screenshots schon herangezogen hatte. In dem behauptet der Autor, GPT-4 sei mit gigantischen Mengen an Text trainiert worden und nennt als mögliche Größenordnung „100 trillion parameters“:

Die Angabe der Parameter bezieht sich nicht auf die Menge der Trainingsdaten!

In diesem Fall werden jedoch zwei verschiedene Aspekte vermischt: Nämlich die Menge der Trainingsdaten, mit denen das Sprachmodell trainiert wurde, und die Anzahl der Parameter, die für die Komplexität und “Intelligenz” des Modells verantwortlich sind. Eine solche Aussage ergibt daher keinen Sinn.

Darüber hinaus verbirgt sich in diesem Satz noch ein weiterer Fehler, der auf einer populären Fehlinformation über GPT-4 basiert: An vielen Stellen wird die Anzahl der Parameter von GPT-4 mit „100 trillion“ angegeben, was im Deutschen 100 Billionen entspricht.

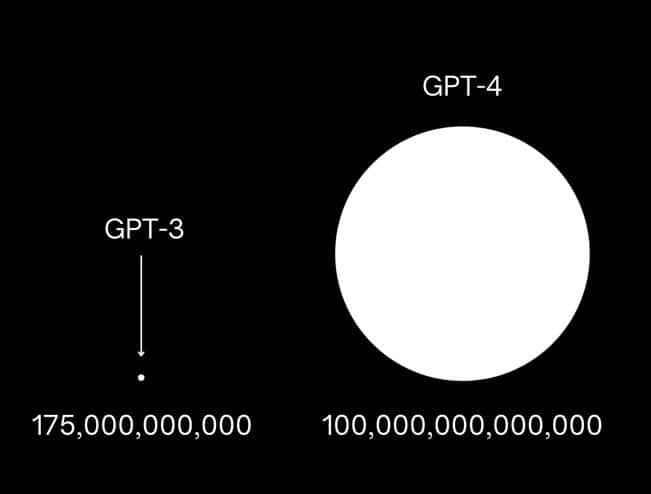

Vielleicht hast Du sogar schon einmal diese Grafik gesehen, die die Anzahl der Parameter von GPT-4 im Vergleich zu dessen Vorgänger GPT-3 anschaulich machen soll. Für ein paar Tage war das die am häufigsten geteilte Grafik bei LinkedIn:

Anschaulicher, aber falscher Größenvergleich zwischen GPT-3 und GPT-4

In meinem Beitrag „Nein, GPT-4 hat weder 100 Billionen Parameter noch 1 trillion Parameter“ habe ich mit diesem Missverständnis bereits aufgeräumt und dargestellt, wie es überhaupt zu der Verbreitung einer solchen Falschinformation kommen konnte.

Zitat aus dem Artikel:

„Die Wahrheit ist, dass OpenAI bis heute keinerlei nähere Informationen zu GPT-4s Aufbau veröffentlicht hat. Es ist weder bekannt, inwieweit sich die Architektur im Vergleich zu dessen Vorgänger GPT-3 verändert hat, noch wie viele Parameter genau das Modell hat.“

Fehler 2: Sprachmodelle mit Wissensmodellen verwechseln

Die Modelle hinter ChatGPT, wie GPT-3.5 und GPT-4, sind darauf spezialisiert, menschenähnliche Texte zu generieren, indem sie Sprachstrukturen und Kontext analysieren. Dennoch sind sie keine Wissensmodelle, da sie die Inhalte der Texte nicht wirklich erfassen.

Sprachmodelle können Informationen weder identifizieren noch speichern oder abrufen. Sie enthalten auch keine Datenbank oder strukturierte Informationsspeicherung. Stattdessen berechnen sie schlicht und einfach die Wahrscheinlichkeit einzelner Wörter oder Wortbestandteile basierend auf vorherigen Wörtern in den Trainingsdaten, ohne die Texte in ihrer ursprünglichen Form zu speichern oder wiederzugeben.

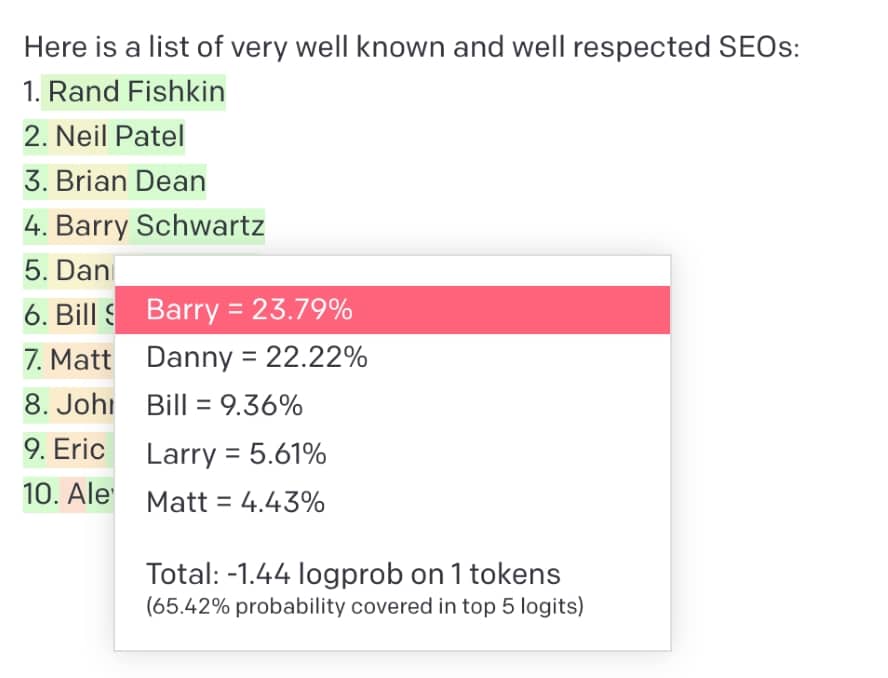

Das wird einem erst so richtig klar, wenn man sich einmal die Wahrscheinlichkeiten der einzelnen Wörter bzw. Tokens anschaut. In diesem Beispiel habe ich GPT-3 eine Liste der bekanntesten und angesehensten SEOs erzeugen lassen. Wie ein Klick auf „Barry“ verrät, war die Wahrscheinlichkeit, dass statt Barry Schwarz ein gewisser „Danny“ auf Platz 4 liegt, extrem knapp, gefolgt von „Bill“, „Larry“ und „Matt“. Im Kontext SEO folgt auf Barry dann „Schwartz“ und auf Danny dann „Sullivan“ und so entsteht (in diesem Fall) eine Liste tatsächlich existierender Personen.

Anzeige von Wahrscheinlichkeiten des Modells

Es mag verlockend und unterhaltsam sein, ChatGPT nach unbekannten Informationen zu fragen oder Texte erstellen zu lassen, die breites Allgemeinwissen oder gar spezielles Expertenwissen erfordern.

Manchmal funktioniert das sogar erstaunlich gut, aber es ist schwierig festzustellen, wann ChatGPT etwas „erfindet“ oder wann eine Aussage in den Trainingsdaten häufig genug vorkommt, um tatsächlich wahr und nicht zufällig zu sein. Besonders, wenn man sich selbst nicht in dem Fachgebiet auskennt.

Während Deiner Erfahrungen mit ChatGPT ist Dir sicherlich bereits aufgefallen, dass es nicht immer makellos ist. Seine Arbeitsweise kann dazu führen, dass es manchmal sogar bei der Zusammenfassung bestehender Texte Fehlinformationen liefert.

Zudem ist ChatGPT nicht immer auf dem neuesten Wissensstand. Da es auf Texten trainiert wurde, die zu einem bestimmten Zeitpunkt verfügbar waren, kann es vorkommen, dass die Informationen veraltet sind. Daher ist es entscheidend, die generierten Inhalte auf Aktualität und Genauigkeit zu prüfen.

Obwohl sie ihre Grenzen haben, können Sprachmodelle dennoch beeindruckende Ergebnisse erzielen. Trotzdem sollte man jede generierte Aussage zunächst kritisch hinterfragen. Sei also vorsichtig, wenn Du Informationen und Daten von ChatGPT verwendest oder weitergibst. Vergiss nicht, immer einen Faktencheck durchzuführen!

Fehler 3: Annahme, dass ChatGPT auf das Internet zugreifen kann

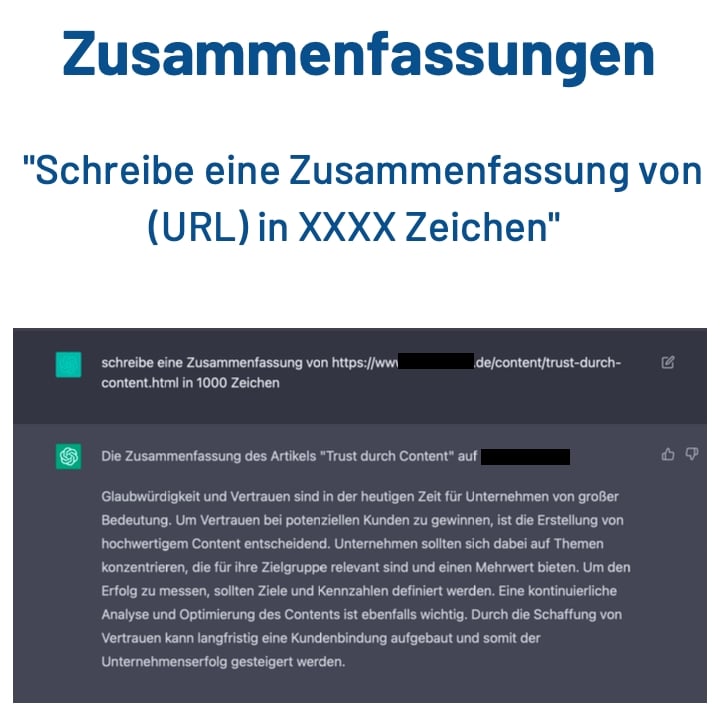

Ein weitverbreiteter Irrtum ist die Annahme, dass ChatGPT auf das Internet zugreifen und Informationen von Webseiten abrufen kann. Tatsächlich ist ChatGPT derzeit nicht in der Lage, live auf Webinhalte zuzugreifen oder den exakten Text einer URL aus den Trainingsdaten herauszufiltern.

Wenn eine URL in einer Eingabeaufforderung verwendet wird, verwendet ChatGPT die darin enthaltenen Wörter lediglich, um eine Antwort zu generieren, die so aussieht, als hätte es die Webseite tatsächlich besucht.

Beispiel für unsinnige Prompts, die auf LinkedIn geteilt werden

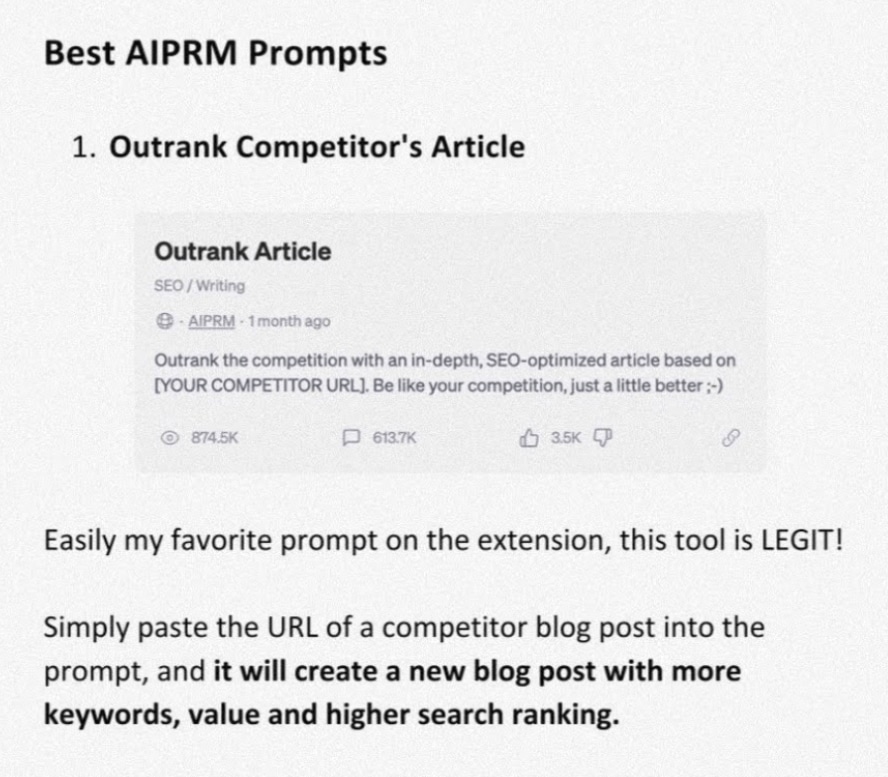

Es ist ebenso unzutreffend anzunehmen, dass man ChatGPT durch einen sogenannten „Outrank Article-Prompt“ dazu bringen kann, einfach einen besseren Artikel als den eines Wettbewerbers zu verfassen.

Diese Idee findet sich in zahlreichen ChatGPT-Leitfäden und Prompt-Communities, wird aber auch von einigen SEO-Experten und Expertinnen verbreitet, die offensichtlich nicht verstehen, was dabei tatsächlich geschieht.

Wie schön wäre es, wenn es nur so einfach wäre. Ist es aber nicht. Das ist Unfug!

Es sei jedoch darauf hingewiesen, dass OpenAI derzeit an Plugins für ChatGPT arbeitet, die genau dieses Problem lösen könnten und sogar bereits ein neues Modell testet, das auf das Internet zugreifen kann.

Dieses sogenannte Browsing-Modell befindet sich allerdings noch in der Alpha-Phase und ist nur einer sehr begrenzten Anzahl von Testnutzern zugänglich. (Quelle: openai.com)

Fehler 4: ChatGPTs Selbsteinschätzung ist oft ungenau

ChatGPT bezieht sein gesamtes Wissen aus der Analyse riesiger Textmengen, was bedeutet, dass es bei Fragen zu Details über sich selbst nicht sehr zuverlässig ist. Zum Beispiel kann ChatGPT keine genauen Angaben darüber machen, wie viel Prozent der Trainingsdaten in einer bestimmten Sprache vorliegen oder wie oft bestimmte Webseiten oder Autoren bzw. Autorinnen in den Trainingsdaten vorkommen.

Zwar bekommt ChatGPT einige grundlegende Informationen über sich selbst durch sogenannte System-Prompts von den Entwicklern und Entwicklerinnen mitgeteilt, wie zum Beispiel seinen Namen, dass es ein Chatbot ist und neutral sowie sachlich antworten soll.

Allerdings erfindet das Sprachmodell hinter ChatGPT bei anderen spezifischen Detailfragen einfach Antworten basierend auf Wortwahrscheinlichkeiten.

In dem folgenden Beispiel behauptet ChatGPT zunächst, es sei ausschließlich mit englischen Texten trainiert worden, nur um später zuzugeben, dass auch deutsche Texte in den Trainingsdaten enthalten sein könnten:

Vorsicht bei Aussagen zu ChatGPT!

Nutze ChatGPT also nicht, um Informationen über ChatGPT selbst zu erhalten. Die benötigten Informationen, um solche Fragen zu beantworten, waren im September 2021 noch gar nicht in den Trainingsdaten vorhanden!

Fehler 5: ChatGPTs Ausgabebegrenzung ignorieren

Beim Stöbern auf YouTube zum Thema ChatGPT stößt man schnell auf Videos, in denen behauptet wird, dass jemand mit ChatGPT ein Buch geschrieben und es dann über Amazons Kindle Direct Publishing Programm erfolgreich verkauft hat. (Quelle: amazon.com)

Wer sich eingehender mit ChatGPT befasst, erkennt jedoch schnell, dass solche Versprechungen Lockangebote von zweifelhaften Geschäftsleuten sind, denn technisch gesehen kann ChatGPT kein ganzes Buch verfassen!

Die maximale Ausgabe des Sprachmodells begrenzt sowohl die Länge der Anweisung an ChatGPT als auch die maximale Länge der KI-Antwort. Abhängig vom verwendeten Modell kann ChatGPT bis zu 1.700 Worte auf einmal ausgeben.

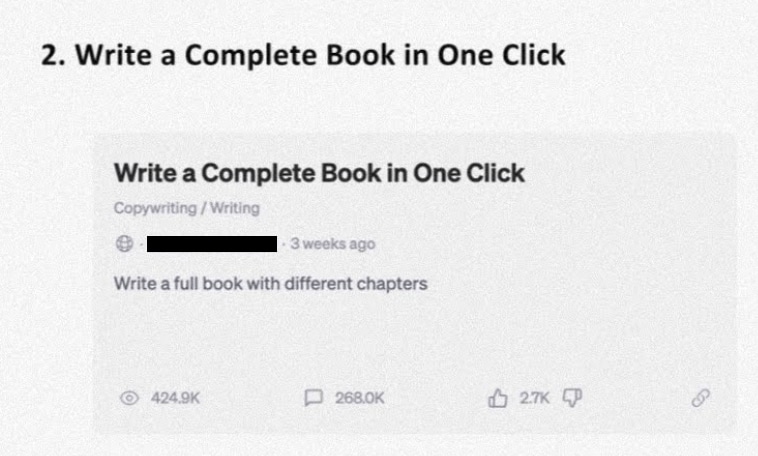

Trotzdem behaupten einige selbst ernannte ChatGPT-Experten und Expertinnen, dass es möglich sei, ein komplettes Buch mit nur einem Klick zu erstellen.

Der Autor hat diesen Prompt bestimmt nie selbst ausprobiert

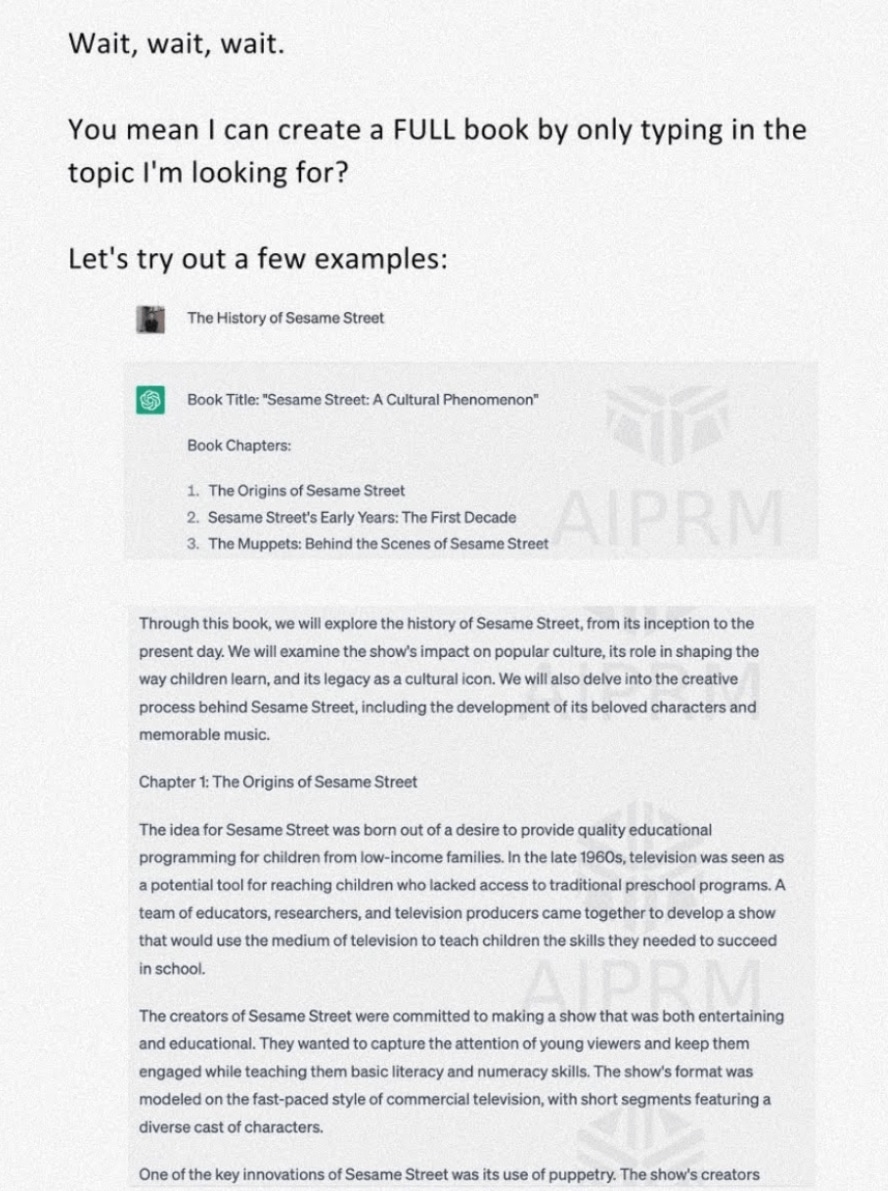

Interessanterweise gibt es kaum kritische Kommentare zu solchen irreführenden Vorschlägen aufseiten wie AIPRM, da anscheinend niemand mehr als den Anfang des generierten Buches betrachtet:

Den Anfang eines Buches bekommt ChatGPT wunderbar hin, doch wie geht es danach weiter?

Natürlich könnte man ChatGPT dazu bringen, die Ausgabe immer wieder fortzusetzen und die erzeugten Teile anschließend in ein Dokument zu kopieren. Allerdings würde die Geschichte dann weder einen roten Faden noch eine konsistente Handlung aufweisen.

ChatGPT kann aufgrund der beschränkten Eingabe zum Beispiel den Anfang des Buches nicht mehr „sehen“, wenn es das nächste Kapitel verfasst, obwohl es diesen selbst verfasst hat und er noch im Chatverlauf steht.

Dadurch ändern sich zum Teil einfach die Namen von Charakteren, die Orte der Handlung, die Handlung springt absurd hin und her oder Handlungsstränge wiederholen sich. So wirkt das Ganze schnell wie eine zufällige Aneinanderreihung von Kapiteln aus verschiedenen Büchern und nicht wie eine stringente Geschichte.

Es erfordert wahre Kunstfertigkeit, ChatGPT bei jeder Anfrage den Gesamtzusammenhang der Geschichte erneut klarzumachen und genau zu erklären, an welchem Punkt der Handlung es sich gerade befindet, damit die einzelnen Kapitel detailliert und fesselnd erzählt werden, ohne den Überblick über das große Ganze zu verlieren.

Fehler 6: ChatGPTs Eingabebegrenzung ignorieren

Wie bereits angedeutet hat ChatGPT sowohl bei der Eingabe als auch bei der Ausgabe seine Grenzen. Wenn Du versuchst, einen zu langen Text umzuschreiben, zusammenzufassen oder zu übersetzen, erhältst Du zwar eine Fehlermeldung, aber einige selbst ernannte „Prompt Engineers“ haben bereits den Ansatz entwickelt, längere Texte in kleinere Abschnitte aufzuteilen und sie der KI nacheinander zu präsentieren. Anschließend bitten sie ChatGPT, den gesamten Text zu verarbeiten.

Dieser vermeintliche Trick führt jedoch unweigerlich dazu, dass ChatGPT sich etwas ausdenkt, da die Beschränkungen des Sprachmodells bei Ein- und Ausgabe dadurch nicht umgangen werden können!

Die einzige Möglichkeit, längere Texte mit ChatGPT zu bearbeiten, besteht darin, den Text Abschnitt für Abschnitt in das Chatfenster zu kopieren und bei jedem Schritt die gewünschte Aktion zu wiederholen.

Das Gesamtergebnis musst Du dann aus den einzelnen Teilergebnissen zusammensetzen. Eine Analyse des gesamten Inhalts auf einmal, wie zum Beispiel das Herausfiltern der Kernaussage, ist dabei leider nicht möglich.

Fehler 7: Themen in einem Chatverlauf vermischen

Wie Dir vielleicht bereits aufgefallen ist, berücksichtigt ChatGPT nur etwa die letzten 1.500 bis 1.700 Wörter in einem Gesprächsverlauf. Das ermöglicht Dir, Rückfragen zu stellen, Formulierungen neu zu gestalten oder Dinge fortzuführen.

Allerdings bedeutet das auch, dass ChatGPT bei jeder weiteren Frage die vorherige Antwort und je nach Länge auch vorherige Fragen und Antworten „sieht“, wenn Du eine neue Aufgabe formulierst.

Nehmen wir an, Du diskutierst zunächst über Ethik mit der KI und möchtest dann plötzlich die Farbe von Äpfeln wissen. Die Antwort könnte viel philosophischer ausfallen, als wenn Du ChatGPT in einem neuen Gesprächsverlauf nach der Farbe von Äpfeln fragst.

Am besten startest Du für jede neue Aufgabe oder zumindest für jedes neue Thema einen neuen Chat mit ChatGPT. So stellst Du sicher, dass frühere Informationen und Anweisungen Dich nicht daran hindern, die neue Aufgabe effektiv zu bewältigen.

Fazit und Tipps für den Umgang mit ChatGPT

Nachdem Du die sieben häufigsten Fehler im Umgang mit ChatGPT kennengelernt hast, kannst Du nun diese beeindruckende KI-Technologie effektiver und zielgerichteter für Dein Schreiben einsetzen. Aber denk daran: Die Welt der generativen Künstlichen Intelligenz steckt noch in den Kinderschuhen, und es gibt so viel mehr zu erkunden und zu lernen.

ChatGPT ist letztendlich ein Werkzeug, dessen Effektivität von der Person abhängt, die es verwendet. Man könnte sagen, dass die KI nur so clever ist wie derjenige, der sie steuert. Um wirkungsvolle ChatGPT-Prompts zu erstellen, braucht es sorgfältige Planung und Liebe zum Detail. Achte darauf, dass Du nicht unabsichtlich Fehler machst, die Deine Prompts und die Qualität der Ergebnisse beeinträchtigen könnten.

Stelle sicher, dass Du ChatGPT genug Kontext und Informationen bietest, um den Zweck des Gesprächs zu verstehen. Halte Deine Aufforderungen prägnant und verzichte auf unnötige Details oder Anweisungen.

Offene Fragen können hilfreich sein, um ausführlichere Antworten zu erhalten, aber zu vage oder unklare Aufforderungen können verwirrend sein und das Verständnis von ChatGPT erschweren. Gib genügend Kontext und Hinweise, um das Gespräch in die richtige Richtung zu lenken.

Um noch tiefer in die Materie einzutauchen, solltest Du Dir das erste fundierte Sachbuch zum Schreiben mit KI nicht entgehen lassen. Es basiert auf meiner Erfahrung mit GPT-3 und dem neuesten Sprachmodell GPT-4.

Mein Buch „Richtig Texten mit KI: ChatGPT, GPT-4, GPT-3 & Co.“, das am 23. Mai im mvg Verlag erscheint, liefert Dir alle Informationen, die Du zum KI-gestützten Schreiben brauchst.

Es zeigt Dir, wie Du ChatGPT und andere KI-Text-Tools optimal nutzen kannst – sei es für Blogbeiträge, Artikel, Slogans, Werbetexte, wissenschaftliche Arbeiten oder kreative Texte. Hier findest Du die Anleitungen und das nötige Hintergrundwissen, um erfolgreich durchzustarten.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

In Bezug auf die übertrieben euphorischen Eigenschaften, die in so manchen “Büchern” über ChatGPT verbreitet werden, kann ich Herrn Spriestersbach als Autor nur zustimmen.

Auch die physikalischen und mathematischen Fähigkeiten sind begrenzt. Und WolframAlpha dürfte hier eine sinnvolle Ergänzung sein. Trotzdem kann man mit ChatGPT ganz gut programmieren lernen bzw. Programme schreiben lassen, was ich in “ChatGPT, OpenAI und der blaue Planet” auch darstelle. Es ist eben ein “stochastischer Papagei”, dem man immer genau auf den “Schnabel” sehen muß – anderenfalls wird grenzenlos phantasievoller Unsinn verzapft.