Wirkungsvolle Texte schreiben wir nicht mehr allein. Large Language Models (LLM) wie ChatGPT entwickeln sich zu festen Teammitgliedern, die alle Prozessstufen im Marketing begleiten. Statt selbst zu schreiben, prompten Copywriter:innen.

Es ist der Skill des neuen Internet-Zeitalters, der Pionierstatus besitzt und sich gleichzeitig zu einer nicht erwähnenswerten Fähigkeit entwickelt. Setzen sich Large Language Models wie erwartet flächendeckend durch, ist das Prompting mit dem Status des Schreibens gleichzusetzen:

Wir alle müssen es beherrschen. Nicht nur Marketer:innen, sondern auch Kindergärtner:innen, Lehrer:innen oder Ingenieur:innen.

Denn LLMs können viel mehr als einfach nur Texte verfassen. Sie analysieren Zielgruppen, präzisieren Aufgaben, stellen eigene Werke kritisch infrage, liefern Content-Ideen und bereiten den Input ganzheitlich auf. All das mit dem Ziel, den Output außerhalb der Software verwenden zu können.

Sprich: Kindergärtner:innen lassen von ChatGPT künftig Verhaltensanalysen und Beobachtungsprotokolle erstellen, Lehrer:innen planen ihren Unterricht und Ingenieur:innen erstellen ganze Prototypen mit den Modellen.

Text ist somit nicht gleich Text.

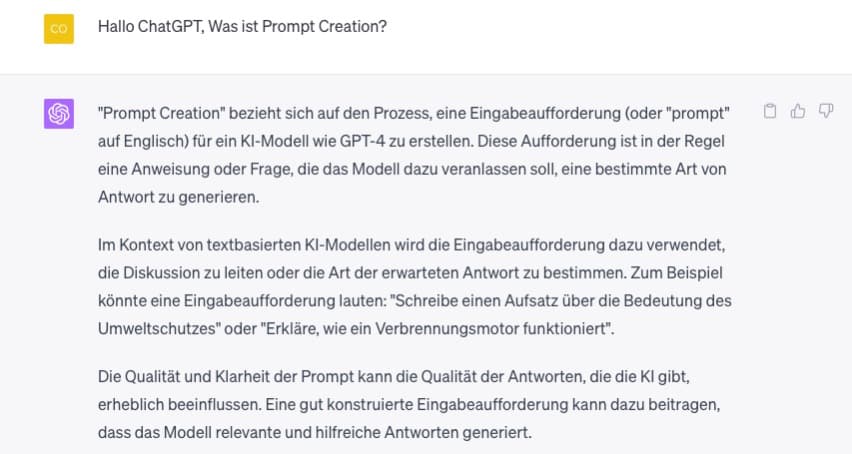

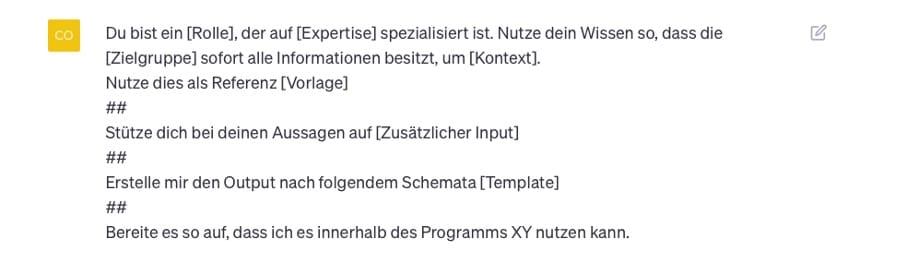

Definition des Begriffs Prompt Creation in ChatGPT.

In LLMs erledigst Du so gut wie jeden Task: Deine nächste Reiseplanung, Marketing Kampagnen, Q&As auf der Webseite, individualisierte Verkaufsmenüs im E-Commerce-Shop, ein auf Ton basierendes Interview oder ganze Datenbanksysteme. All das ist Text.

Was ein Prompt ist, wie Dir die Prompt Creation für Texte gelingt und wie Du Prompts effektiv für das Marketing einsetzt, erfährst Du in diesem Artikel Schritt für Schritt.

Tauchen wir also ein in die Welt der Prompt Creation!

Teil 1: Was ist ein Prompt? Definition und Fallbeispiel

Um einen Prompt zu kreieren, müssen wir diesen erst einmal definieren. Ein Prompt ist immer ein Input in Form einer ersten Idee für das LLM. Also das, was Du in ein LLM einträgst. Mit jedem Prompt programmierst Du das LLM so, dass es Dir den passenden Output liefert.

Jeder Prompt ist auch eine Anweisung. Du definierst Regeln oder automatisierst den Output.

Kurz gesagt: Du bestimmst anhand der im Prompt enthaltenen Informationen, die Quantität, aber auch Qualität des Ergebnisses (Quelle: Jules White et. al.)

Informationen sind beim Prompting immer kontextgebunden. Was bedeutet das für die Creation?

❎ Statt zu prompten:

Schreibe mir einen Text über den Klimawandel.

✅ Prompte lieber:

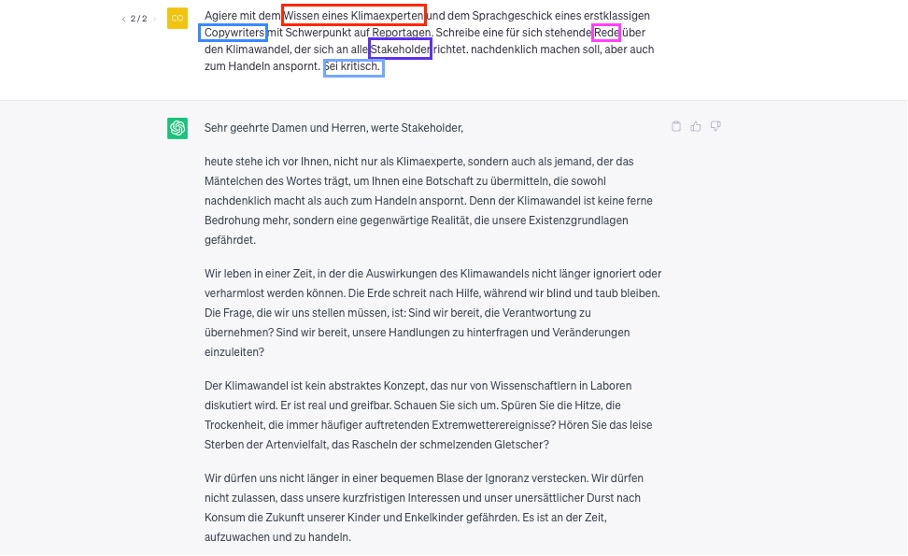

Agiere mit dem Wissen eines Klimaexperten und dem Sprachgeschick eines Copywriters mit Schwerpunkt auf Reportagen. Schreibe eine für sich stehende Rede über den Klimawandel, der sich an alle Stakeholder richtet, nachdenklich machen soll, aber auch zum Handeln anspornt. Sei kritisch.

Generierter Output einer Rede von ChatGPT auf Basis eines Prompts.

In kürzesten Aussagen sind Informationen in höchster Dichte für LLMs kontextuell gebunden. Dröseln wir diese auf:

- Information: Alle Informationen des Texts beziehen sich auf die Rolle, die das LLM einnimmt. Es agiert in der Rolle als Klimaexperte bzw. Klimaexpertin.

- Wording und Stil: Die Ausgabe orientiert sich am Sprachgeschick eines Copywriters bzw. einer Copywriterin. Elemente des Storytellings, aber auch Metaphern, blumige Aussprachen und Symboliken können erkannt werden.

- Format: Wie der textliche Output erfolgt, zeigt das Format an. In diesem Fall hat der Prompt das LLM angewiesen, eine Rede zu konzipieren.

- Zielgruppe: Der Output verändert sich je nach eingegebener Zielgruppe. Die Zielgruppe bildet sich aus allen Stakeholdern.

- Motivation: Welches Wording der Output besitzt, entscheidet der Prompt. Das LLM wurde angewiesen, kritisch und gleichzeitig auffordernd zu formulieren.

Teil 2: Den Output optimieren

Der erste Output ist selten qualitativ. Diese Form des Soft Promptings besitzt eine Reihe an Limitationen. Unter anderem ist je nach LLM ohne weitere Angaben keine Gewichtung der Informationen möglich.

So lässt sich für das LLM schwer einordnen, ob es für Dich nun wichtiger ist, bei einem Text über Prompt Creation über „Prompting“ oder „Creation“ zu schreiben.

Es geht dann von der höchsten Wahrscheinlichkeit aus. Denn genau so funktionieren LLMs: Jeder Output basiert auf Tokens. Jedes Wort eines Satzes wählt das LLM also auf Basis der höchsten Wahrscheinlichkeit aus.

Lautet der Prompt: „Sein oder nicht sein“ berechnet das LLM, was am Ehesten zur Anfrage passt.

Das Ergebnis:

Die Antwort von ChatGPT auf den Prompt „Sein oder nicht sein“.

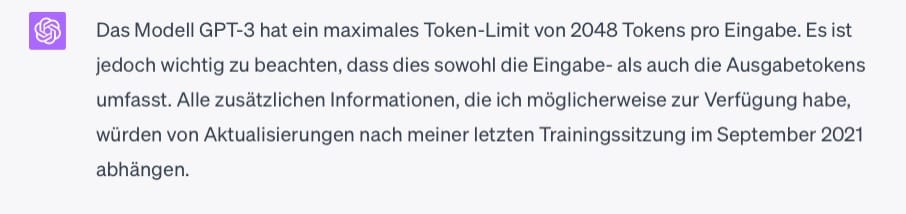

Wie LLMs Tokens berechnen, ist nicht pauschalisiert. Meist ist es jedoch so, dass die Tokens die Anzahl an Wörtern überwiegen. So entstehen aus dem Wort „Edutainment“ zwei Token [Edu;Tainment]. Nicht nur der Output ist von Tokens beeinflusst, sondern auch der Input.

Beim Prompting bist Du in allen LLMs auf eine bestimmte Anzahl Tokens begrenzt.

Informationen zur Limitation der Tokens pro Prompt bei ChatGPT.

Das führt bei komplexen Prompts bereits dazu, dass sich Anforderungen nicht innerhalb eines Prompts abbilden lassen.

Auch ist es bei einer Vielzahl von Creatives nicht möglich, das erwartete Ergebnis nur durch die Eingabe eines Prompts zu erhalten (Quelle: Cambridge University).

Hierfür benötigt es wiederkehrende Muster, repetitive Anforderungen – eine logische Semantik, der das LLM blind folgen kann. Ist diese nicht vorhanden, steuerst Du den Output durch kritisches Hinterfragen.

Teil der Prompt Creation ist somit immer die Qualitätskontrolle.

Vergiss also nicht in den Dialog mit dem LLM zu gehen, um den Output zu verbessern.

Das gelingt in zwei Richtungen:

- Fordere das Large Language Modell dazu auf, erst alle notwendigen Rückfragen zu stellen, bevor es den Output liefert.

Der Output nach allen beantworteten Fragen:Verbesserter Rede von ChatGPT über den Klimawandel, nachdem das LLM alle Informationen eingeholt hat, was es benötigte, um die Anfrage zu beantworten.

- Gib Feedback auf den Output und bitte das Large Language Modell ihn basierend auf dem Feedback umzuschreiben.

Der Output nach der Kritik (dass die eigene Rolle Bestandteil der Rede war und der Fokus mehr auf die Dringlichkeit des Handelns hinweisen soll):Verbesserte Rede von ChatGPT über den Klimawandel, nachdem Feedback auf den ersten Output gegeben wurde.

💡 Dein Learning: Je mehr Du in den Dialog mit LLMs gehst, desto qualitativer ist auch der Output. Du steuerst ihn in der Creation. Die Prompt Creation beinhaltet selten nur den ersten eingegebenen Prompt. Sie beinhaltet auch jegliche Form des Dialogs mit dem LLM.

Exkurs: Chained Prompting

Dieses Wissen unterstützt dabei, die gesamte Ideation- und Creation-Phase für Content innerhalb eines LLMs umzusetzen. Mittels Chained Prompting schreibst Du beispielsweise einen Text qualitativ und im Austausch mit dem LLM.

Bedienen wir uns hierfür wieder dem oberen Beispiel. Du hast das LLM gebeten, einen Text über den Klimawandel in Form einer Rede zu schreiben. Nachdem Du dem LLM bereits Feedback auf den Text gegeben hast, ist die Creation Phase zunächst für Dich abgeschlossen.

Nun erweiterst Du den Content-Prozess durch das Redigieren. Durch Prompts wie

- Lösche Füllwörter wie …

- Ergänze Informationen zu …

- Verdichte die Informationen in Sätzen, indem Du …

- Verändere das Content-Format in …

- Wähle eine andere Ansprache …

- Verzichte auf Aussagen wie …

entstehen Argumentationsketten, die den Text weiter und weiter verändern. Je nachdem, wie weit Du die Argumentationskette treibst, können ganz neue Inhalte daraus entstehen.

Aus einer Rede hast Du es durch diese Methode beispielsweise geschafft, einen LinkedIn-Beitrag oder ein Videoskript zu erstellen. Transformation ist durch Weiterangabe von Befehlen somit sowohl innerhalb eines Formats, aber auch barrierefrei möglich.

Teil 3: Muster in der Prompt Creation verwenden

Mit jedem Prompt programmierst Du den Output. Wiederholst Du eine bestimmte Anweisung immer und immer wieder, entsteht ein logisches Muster, dem das LLM folgt. Muster vereinfachen für Large Language Modells den Output Deiner Erwartung anzupassen. Dies ist auf die erhöhte Wahrscheinlichkeit des korrekten Outputs zurückzuführen.

Was zunächst sehr komplex klingt, vereinfacht tatsächlich die Creation für Dich. Wenn Du es schaffst, Dein Wissen in ein Muster zu übertragen, kodierst Du die Informationen.

Das ermöglicht dem LLM, das Muster auf weitere Kontexte, aber auch Formate zu übertragen. Das LLM ist plötzlich in der Lage, eine Transferaufgabe zu lösen.

Solche Muster kannst Du entweder selbst durch Eingabe von Prompts programmieren oder Du bedienst Dich jener, die bereits vorhanden sind.

Das sind die bekanntesten Muster, die Du für Deine Prompt Creation nutzen kannst (Quelle: Jules White et al.):

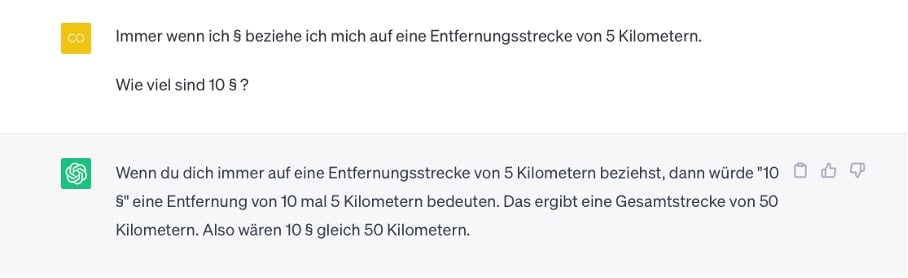

Meta Language Creation

Persona Muster

Refine Muster

Umgekehrte Interaktion

Fact-Check-List-Muster

➡️ Meta Language Creation: Prompting einer benutzerdefinierten Sprache

Eingabe und generierter Output im Rahmen der Meta Language Creation in ChatGPT.

💡 Mit diesem Muster legst Du die Interpretation von Parametern fest. Diese muss immer eindeutig sein.

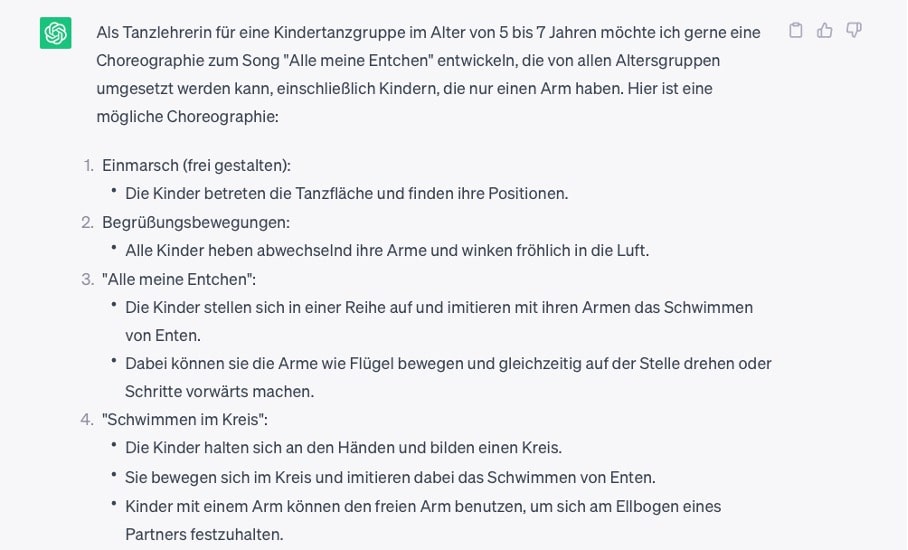

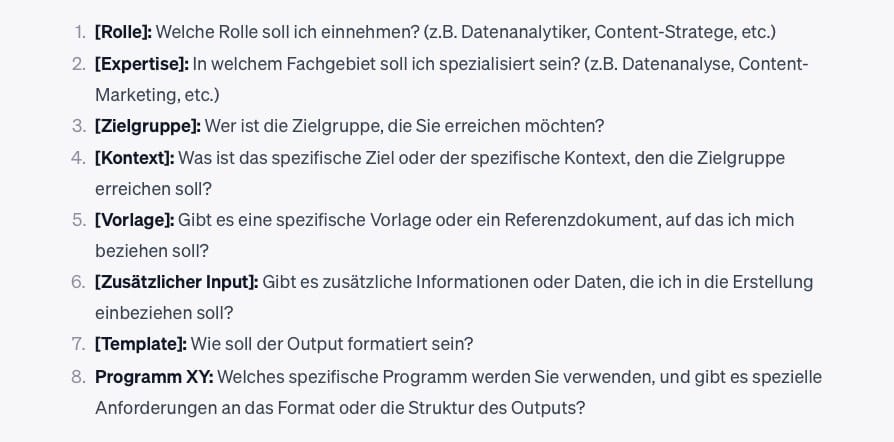

➡️ Persona Muster: Dem LLM eine bestimmte Benutzerrolle zuordnen

Eingabe und generierter Output unter Verwendung des Persona Patterns in ChatGPT.

💡 Das LLM liefert den Output so, wie die vergebene Rolle es tun würde

➡️ Refine Muster: Der Prompt fordert das LLM dazu auf, immer einen besseren Prompt zu entwickeln.

Eingabe und generierter Output unter Verwendung des Refine Musters in ChatGPT.

💡 Die LLM wird zum Lehrenden und zeigt Dir, wie Du effizienter promptest und so bessere Ergebnisse erzielst.

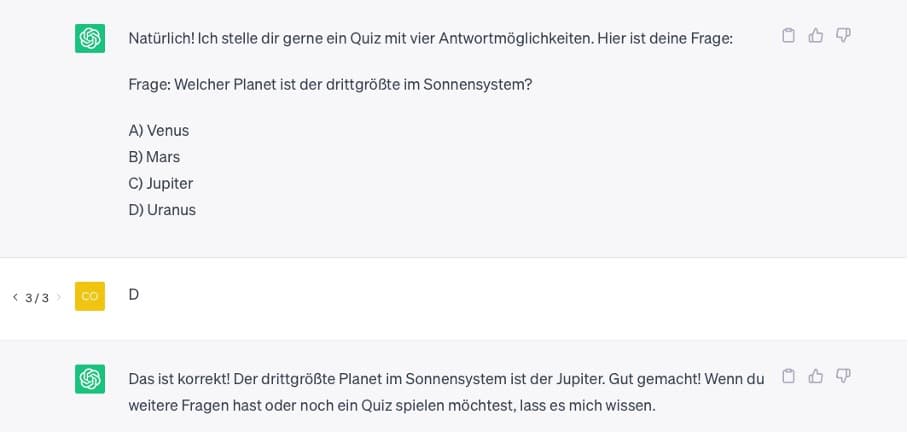

➡️ Umgekehrte Interaktion: Lasse LLMs durch Prompting zum Fragesteller werden

Eingabe und generierter Output im Rahmen der umgekehrten Interaktion in ChatGPT.

💡 Der Output wird durch neue Möglichkeiten wie Gameplay, aber auch neues Wissen ergänzt.

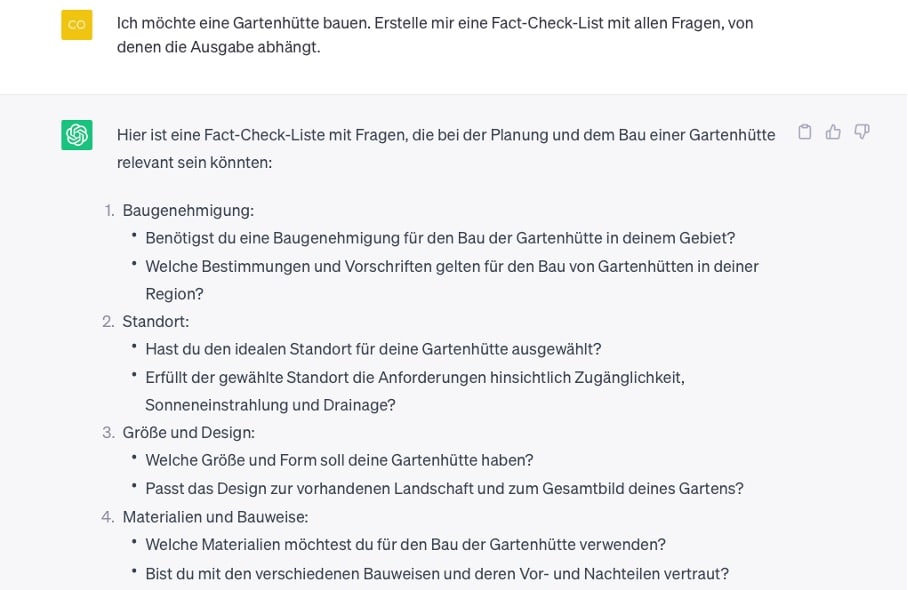

➡️ Fact-Check-List-Muster: Das LLM erstellt eine Reihe an Fragen, von denen die Ausgabe abhängt.

Eingabe und generierter Output unter Verwendung des Fact Check-List-Musters in ChatGPT.

💡 Das LLM übernimmt Teile der Qualitätskontrolle.

Exkurs: Soft Prompting mit Vorlagen

Für wenige Anwendungsfälle kann das Soft Prompting im One-Shot-Verfahren ausreichen. Wenn Du Large Language Modells eine Vorlage für den Output gibst, erstellt das LLM den Output analog.

Damit die Prompt Creation im One-Shot-Verfahren gelingt, ist die Komplexität so gering zu halten wie möglich. Gleichzeitig müssen alle Informationen kontextgebunden vorliegen.

Ein Prompt für das One-Shot-Verfahren wäre:

Beispielanweisung für die Verwendung eines One-Shot-Prompts.

Du gibst im One-Shot-Verfahren dem LLM ein eindeutiges Rezept vor, nachdem es vorgeht. Du bedienst Dich somit der Fähigkeit des LLMs, Muster zu erkennen und diesen Schritt für Schritt zu folgen. Alle Informationen in eckigen Klammern bieten Raum für erweiterte Informationen.

Diese kannst Du direkt in Deinen One-Shot-Prompt inkludieren. Sollten die Tokens aufgrund der Datendichte nicht ausreichen, bietet sich das Few-Shot-Verfahren an.

In diesem Fall hältst Du den ersten Prompt noch unspezifisch und stellst erst im Laufe der Konversation alle Inhalte pro Klammer bereit.

Hier sind einige Beispiele, wie Du LLMs innerhalb von Klammern Anweisungen gibst:

Beispiele für die Verwendung von Klammern für die Angabe selektierter Informationen in ChatGPT.

Teil 4: Wie Du Prompts in der Creation präzisierst

Verstehen wir Prompting als Training, gibt es mehrere Möglichkeiten, um durch einfaches Lernen die Prompts zu verbessern. Auch das LLM trainiert stetig. Mit jeder neuen Dateneingabe verbessert sich der Output.

Trotz dessen, dass LLMs wie ChatGPT mittlerweile auch Zugang zu Daten im Internet bieten (zumindest in der Betaversion) wurden sie vorwiegend auf englischen Daten trainiert.

Gleichzeitig hilft uns das Wissen, dass LLMs auf Basis von Wahrscheinlichkeiten Output generieren, dass wir durch die Verwendung von Mustern den Output verbessern.

Die folgenden Punkte dienen Dir als Cheat-Sheet für Deine nächste Prompt Creation:

- Wechsel die Sprache Deines Prompts, um den Output zu verändern und auf alternative Daten zurückzugreifen.

- Teile mit LLMs Vorlagen und Referenzen, wie Du Dir den Output vorstellst. Via Plugins gelingt das auch in Form von Dokumenten wie PDFs.

- Unterteile Vorlagen und Anweisungen durch Zeichen (Vorlage##Anweisung##Frage an das LLM).

- Trenne Aussagen durch Kommata (lockere Tonalität, 1000 Wörter, Zielgruppe Marketer).

- Nutze Trennzeichen wie XML-Tags, um Aussagen für das LLM hervorzuheben.

- Setze auf Scoring-Modelle, um dem LLM eine Gewichtung vorzugeben.

- Definiere die Zielsprache (übersetze den Prompt in ein Python-Skript).

- Definiere das Format (Tabellarische Darstellung, Code, Text, Bild, Video …).

Teil 5: Breaking the Pattern: Wie Du einzigartigen Output kreierst

Da Large Language Modells sich an Mustern trainieren, wirkt der generierte Output hin und wieder generisch oder entspricht nicht Deiner Erwartung. Jetzt ist es an der Zeit, Outside-the-Box zu denken. Dabei gilt es sich daran zu erinnern, dass Kommunikation nicht nur eine Ebene besitzt.

Funktionieren die Muster nicht, um das eigene Problem zu lösen, musst Du diese brechen. Hierfür gibt es viele Wege.

Limitationen von ChatGPT.

Zwei kommen am häufigsten vor:

1. Gib der LLM Informationen, die sie noch nicht besitzt.

2. Lasse Dich von der LLM anleiten.

1. Das Large Language Modell mit Informationen füttern

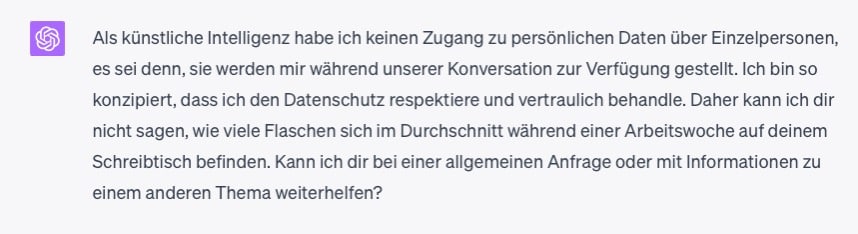

LLMs werden mit einer Fülle an Daten trainiert. Gerade sensible Daten wie Unternehmensdaten, persönliche Charakteristiken oder Dein Gedankengut kennt das LLM nicht. Um passenden Output zu erzeugen, fütterst Du das LLM mit diesen an.

Innerhalb eines Chats mit dem LLM kannst Du jederzeit neue Informationen hinzufügen, die das Ergebnis beeinflussen. Bei einer großen Fülle an Daten zieht dies im Zweifel hohe Kosten nach sich, wenn die LLM-Budgetierung nach Tokens erfolgt.

Hinzufügen von neuen Informationen, damit ChatGPT die Anfrage beantworten kann.

Was Du tun kannst, um vorab Daten zu selektieren, die wichtig für die Ausgabe sind?

- Nur spezifische Dokumente an das LLM übergeben

- Daten nach Relevanz mit Dritt-Tools sortieren

- Dem LLM Vorlagen erstellen, wie es den Output liefern soll

Beachte bei der Dateneingabe immer die Sensibilität von Daten. Wie die LLM die Daten verwendet, ist häufig unklar. Die Datenschutzkriterien sollten somit auch beim Prompting beachtet werden.

Die Eingabe von erweiterten Informationen ist immer empfehlenswert, um den Output gezielter und auf Basis aller notwendiger Daten zu steuern. Zusätzlich empfiehlt sich ein solcher Ansatz, um eigene Creatives zu optimieren.

💡 Praxisimpuls: Kopiere doch einfach mal den nächsten Text von Dir in ein LLM und lasse ihn auf Grammatik, Sinnhaftigkeit, Füllwörter oder auf das Zielgruppenverständnis überprüfen.

2. Das LLM wird zum Coach

Wolltest Du schon einmal eine Rakete bauen, weißt aber nicht, wie es funktioniert?

Eine Webseite erstellen, aber weißt nicht, was ein CMS ist?

Ein Social-Media-Reporting erstellen, aber Du hast es noch nie gemacht?

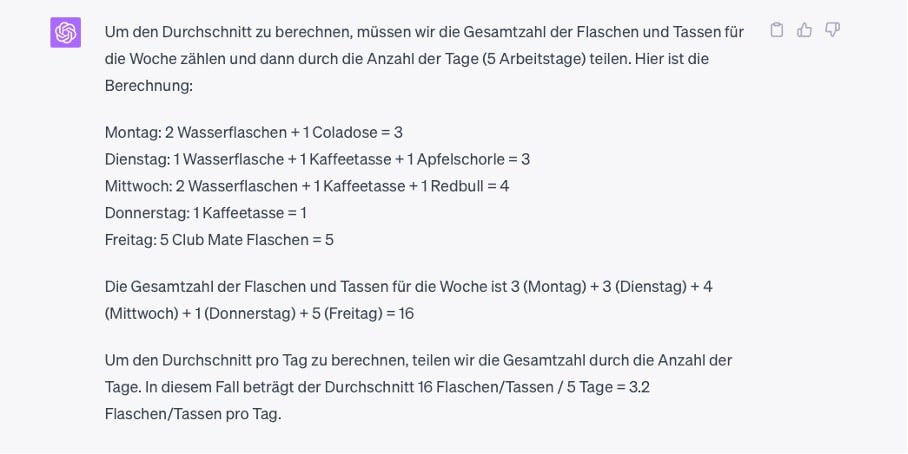

Prompt Creation, um ChatGPT in einer Beratungsfunktion zu nutzen.

Dann kann das LLM noch heute Deine Weiterbildung übernehmen. Mit Deinen Prompts bringst Du das LLM dazu, Dein Problem zu lösen und Dich Schritt für Schritt an die Aufgabe heranzuführen.

Wenn Du besonders gut promptest, zeigt Dir das LLM nicht nur den Lösungsweg auf, sondern unterstützt auch mit Hilfestellungen oder gibt Dir im Anschluss die gesamte Lösung aus.

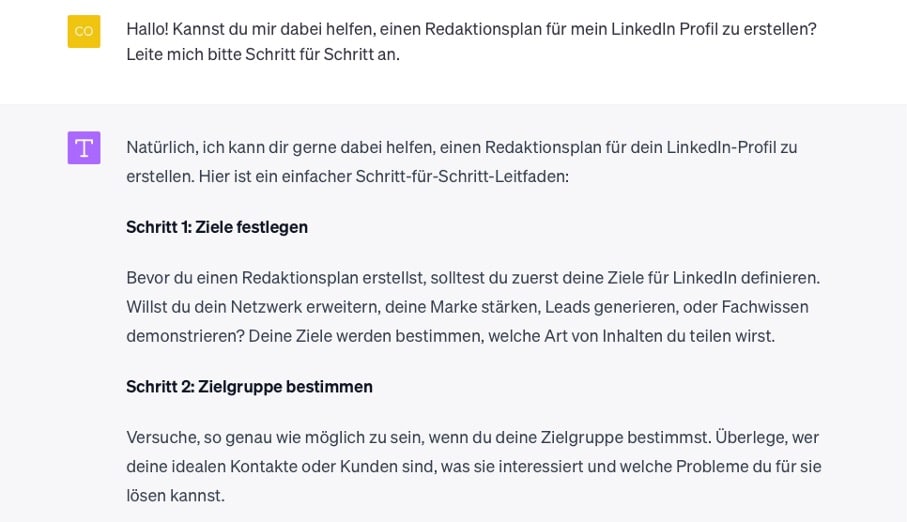

Ausgabe eines Redaktionsplans von ChatGPT.

In unserem Beispiel zeigt das LLM nicht nur, wie wir einen Redaktionsplan aufbauen, sondern bietet auch eine Vorlage und gibt Hinweise dazu, in welchem Tool wir diesen am besten aufbauen können.

Die Anfrage würde sich durch Prompting nun noch weiter anpassen lassen, um auch im Redaktionsplan alle gewünschten KPIs und Informationen hinterlegt zu haben.

Fang hier also gerne an zu experimentieren und lerne jeden Tag kostenlos dazu.

LLMs stehen Dir als Coach 24/7 zur Verfügung. Das kannst Du für jede Frage und jedes Problem nutzen.

Teil 6: Dein Prompt existiert außerhalb des Large Language Modells

Das übergeordnete Ziel des Promptings ist es, Outputs zu erschaffen, die auch außerhalb des LLMs funktionieren. Redaktionspläne wie im Beispiel zuvor lassen sich aus dem Programm heraus exportieren und in genannten Tools wie Excel oder Google Sheets nutzen.

Du kannst größer denken. LLMs sind Sprachjongleure und beherrschen jede Sprache, die Du Dir vorstellen kannst. Der größte Trumpf in der Hand: LLMs beherrschen Programmiersprachen aus dem Effeff.

Warum also nicht einen Redaktionsplan erstellen, der automatisiert Input liefert, sich mit Datenbanken verknüpft und sich so selbst pflegt?

Warum nicht ein Quiz für die eigene Webseite erstellen?

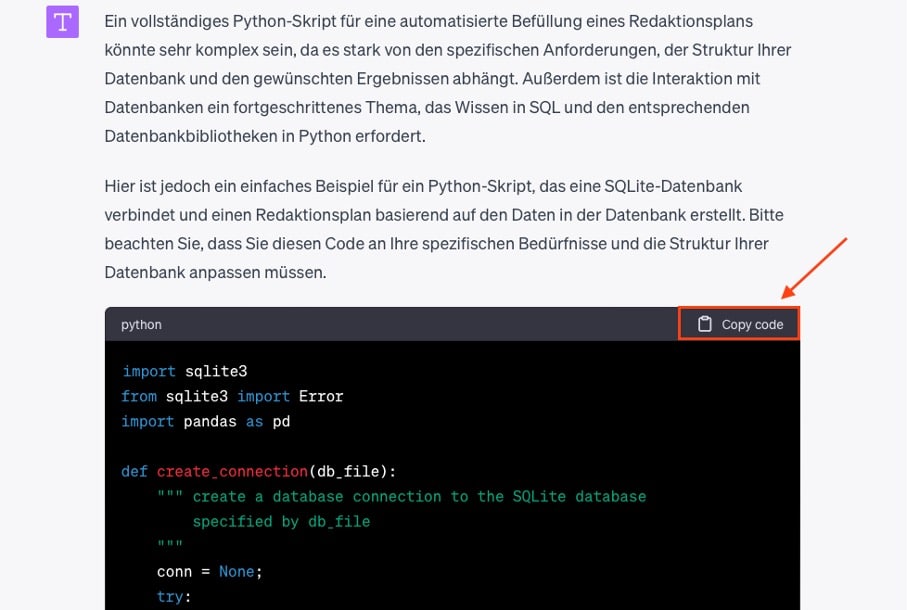

Ausgabe eines Redaktionsplans in Form eines Python-Codes in ChatGPT.

Erstellte Codes in LLMs lassen sich kopieren und so in Drittprogramme einarbeiten. Dabei gehen LLMs gewissenhaft vor und informieren darüber, dass der gegebene Code wahrscheinlich nicht meinen Anforderungen genügt.

Wir sehen anhand dieses Beispiels aber, dass LLMs mehr als nur Text und Grafiken kreieren können. Sie können ganze Welten kreieren. Durch Verfeinerung des Prompts gelingt dann auch die Codierung eines benutzerspezifischen Skripts.

Herzlichen Glückwunsch, Du hast erfolgreich einen Prompt kreiert, der neue Welten außerhalb des LLMs erschlossen hat.

Fazit: 5 Schlüsselfaktoren für die Prompt Creation

Mit jeder neuen Prompt Creation befindest Du Dich erneut auf einem grünen Feld, auf dem alles möglich ist. Beim Prompting kannst Du Dich sowohl auf Muster stützen oder diese durchbrechen, Anweisungen an das LLM geben oder es Dich leiten lassen.

Wichtig ist es, offen für Neues zu bleiben und ohne Limitationen bei der Prompt Creation zu denken. So gelingt es Dir, Prompts zu kreieren, die außerhalb eines LLMs funktionieren und echte Mehrwerte bieten.

🔑 Prompts sind das Briefing an die KI

🔑 Prompts sind immer kontextgebunden

🔑 Prompts sind repetitiv

🔑 Prompts beinhalten alle notwendigen Informationen

🔑 Prompts sollen Output kreieren, der außerhalb der LLMs funktioniert

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen