Künstliche Intelligenz, ChatGPT und Prompts sind wahrscheinlich die am häufigsten verwendeten technischen/wirtschaftlichen Begriffe der letzten sechs Monate.

Wenige Technologien haben sich in so kurzer Zeit so schnell entwickelt, Berufsfelder und Berufsbilder verändert und Arbeitsweisen revolutioniert. Viele sprechen über KI und diskutieren Möglichkeiten und Risiken.

Im vorliegenden Artikel beleuchten wir das Thema Prompting und Prompt Engineering für die Texterstellung und Generierung anderer Inhalte näher.

Kurzeinführung in die generative Künstliche Intelligenz

Generative KI bezeichnet den Teil der Künstlichen Intelligenz, mit dem Texte, Bilder, Videos, Audios, Programmcode und vieles mehr erstellt werden. Die Basis dafür sind in der Regel ein Text-Prompt und je nach Anwendung weitere andere Medien, die angepasst oder als Basis verwendet werden.

Die Möglichkeiten von generativer KI sind vielfältig und können in verschiedenen Bereichen eingesetzt werden. So kann sie beispielsweise in der Kunst verwendet werden, um neue und einzigartige Kunstwerke zu schaffen, die von eine meiner menschlichen Künstler:in allein nicht möglich wären.

Auch in der Musikindustrie kann generative KI eine Rolle spielen, indem sie neue Songs und Melodien generiert, die von einem menschlichen Komponisten bzw. einer Komponistin inspiriert sind.

Darüber hinaus kann generative KI auch in der Programmierung eingesetzt werden, um automatisch Code zu generieren, der bestimmte Aufgaben erfüllt. Dies kann die Arbeit von Entwicklern bzw. Entwicklerinnen und Programmierern bzw. Programmiererinnen erheblich erleichtern und beschleunigen.

Insgesamt bietet generative KI eine Fülle von Möglichkeiten und Anwendungen, die es uns ermöglichen, die Grenzen dessen zu erweitern, was wir mit Technologie erreichen können.

Beispiele für Tools im Rahmen generativer KI Systeme sind z.B.:

- Text: OpenAI, Jasper

- Bilder: MidJourney, Leornado

- Sprache: ElevenLabs

- Code: CoPilot

Der Markt für generative KI wird laut McKinsey von 40 Milliarden Dollar in 2022 auf 1,3 Billionen Dollar im Jahr 2032 wachsen, das entspricht einem Wachstum von 42 % pro Jahr (linkedin.com)

Large Language Models

Die Grundlage für die generativen KI-Anwendungen sind sogenannte Large Language Models (kurz LLMs). Diese werden auf der Basis von Daten trainiert und in der Regel durch menschliches Feedback optimiert. Die Fähigkeiten der Anwendungen basieren daher immer auf demjenigen Input, den die jeweiligen Modelle erhalten haben.

Um Abfrageergebnisse besser interpretieren zu können, muss man verstehen, welche Algorithmen hinter den LLMs liegen, wie diese Sprachmodelle funktionieren und die eigenen Prompts verarbeitet werden.

Die GPT-3.5 Architektur von OpenAI wurde auf der Basis der folgenden unstrukturierten Daten zum Stichtag Juni 2021 trainiert:

- 3,2 Milliarden Webseiten aus Web Corpus inklusive Bilder, Links und archivierte Texte

- 45 Millionen Webseiten (WebText2), die auf Reddit besonders gut bewertet wurden

- 200.000 Bücher (nicht alle Bücher der Welt)

- Englische Wikipedia-Seiten

Auf dieser Grundlage wurden dann weitere Mechanismen wie Supervised Finetuning, Reward Modeling und Reinforcement Learning by Human Feedback angewendet, um das Ergebnis zu verbessern und die Fähigkeiten der LLMs zu spezifizieren. Allein die Kosten für die Bereitstellung der Rechenleistung sollen 3,5 Millionen Dollar betragen haben (zdnet.com/, wikipedia.or, linkedin.com).

ChatGPT ist jedoch nicht die einzige Anwendung bzw. das einzige LLM, mit dem generative KI-Aufgaben erledigt werden können. Derzeit werden auf der Seite Hugging Face pro Woche etwa 5.000 neue Modelle mit sehr unterschiedlichen Fähigkeiten veröffentlicht. Nicht alle Modelle sind jedoch so umfangreich und ganzheitlich wie das von OpenAI.

Es existieren auch spezialisierte Modelle, die ohne weitere Mechanismen wie z.B. Supervised Finetuning bereits gute Ergebnisse liefern. Auf dem Open LLM Leaderboard kann man sich viele Modelle ansehen. (huggingface.co)

Es gibt folglich viele Modelle, die außer ChatGPT genutzt werden können, und das von ihm genutzte Modell ist weder das einzige noch das neueste Modell. Es ist von entscheidender Bedeutung, das richtige Modell für den jeweiligen Anwendungsfall auszuwählen, da die Auswahl des Modells einen erheblichen Einfluss auf das Ergebnis haben kann.

Die Wahl des Modells hängt von verschiedenen Faktoren ab, wie der Art des Textes, der Länge des Textes, dem Zweck des Textes und der Zielgruppe. Je nach Datenbasis generiert das Modell bzw. das entsprechende Tool entsprechend spezifische Ergebnisse für spezielle Themen, Berufsfelder, Anwendungsgebiete oder Aufgabenstellungen.

Darüber hinaus spielen auch die verfügbaren Ressourcen und die verfügbare Technologie eine Rolle bei der Wahl des Modells. Es ist also wichtig, sorgfältig zu prüfen, welches Modell am besten geeignet ist, um das gewünschte Ergebnis zu erzielen. Im Folgenden werden wir uns aufgrund der sehr großen Verbreitung und Qualität auf ChatGPT fokussieren.

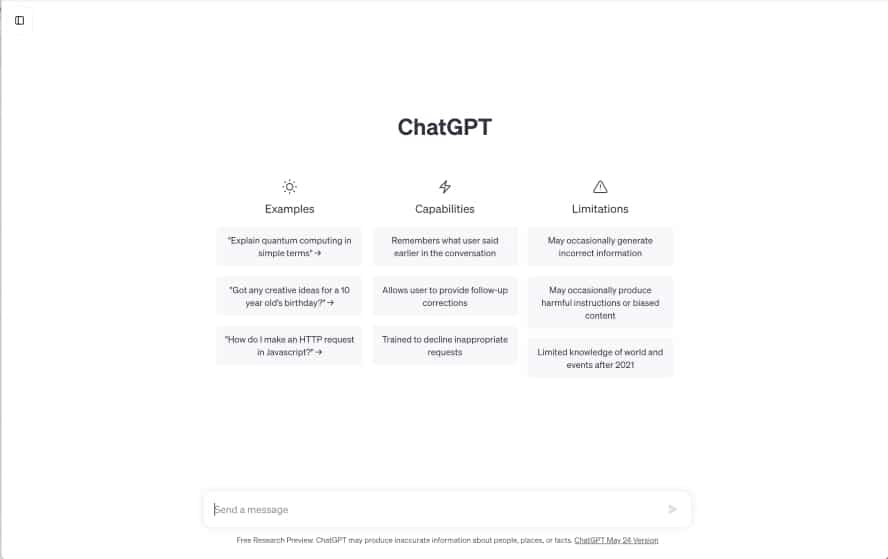

ChatGPT

Die meisten Anwender:innen kennen ChatGPT in Form der Weboberfläche, die einem Chat sehr ähnelt. Über die Texteingabe gibt man sein Prompt ein und ChatGPT antwortet mithilfe seines Sprachmodelles bzw. vervollständigt das Prompt im jeweiligen Chatbot.

Diese sehr einfache Oberfläche ist für viele einfache Anwendungsfälle ausreichend. Es ist jedoch darauf hinzuweisen, dass Prompts und der Chat-Verlauf einer Längenbeschränkung unterliegen, die je nach Modell und Tool bei ca. 4.000 Zeichen liegt.

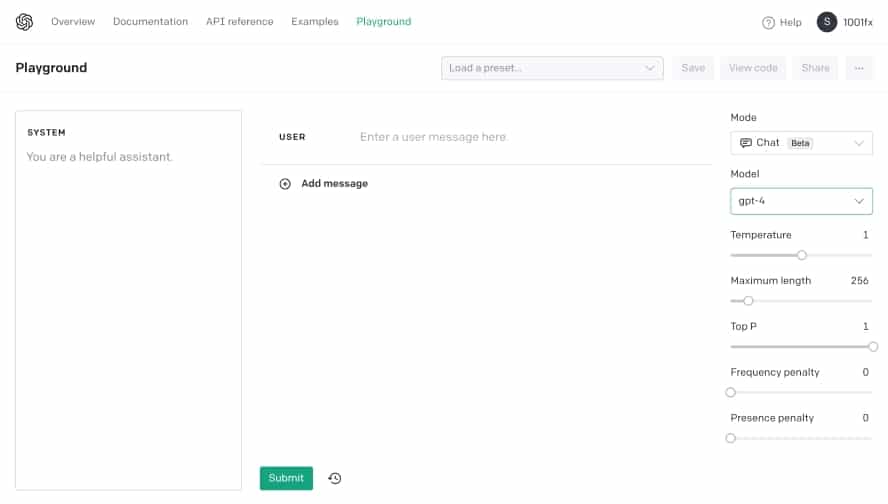

Sobald jedoch komplexere Prompts verwendet werden, lohnt es sich, einen Blick auf die OpenAI API zu werfen, da ChatGPT noch mehr Optionen bietet:

- User Prompt: Das Prompt, das an ChatGPT gesendet werden soll

- System Prompt: Hier kann dem System mitgeteilt werden, wie es sich im Generellen verhalten Beispiele sind: “Du bist ein technischer Redakteur” oder “Du antwortest nur auf englisch”, etc.

- Model: Auswahl des anzuwendenden Models (z.B. gpt-4)

- Temperature: Welche “Temperature” soll für die Antworten verwendet werden (zwischen 0 und 2? Höhere Werte wie 0,8 machen die Ausgabe zufälliger, während niedrigere Werte wie 0,2 sie fokussierter und deterministischer machen.

- Maximum Length: Wie lange sollen die Antworten sein (ein Wort hat ca. 4 Tokens)?

Über diese Oberfläche lassen sich die Ergebnisse des Prompts wesentlich besser steuern und optimieren. Für die Erstellung von idealen Prompts lohnt es sich, die Techniken des Prompt Engineerings etwas näher zu betrachten.

Prompt Engineering

Unter Prompt-Engineering versteht man die Erstellung und Anpassung des Prompts (die Texteingabe und Aufgabenstellung), damit die KI das oder die richtigen Ergebnisse liefert. Je nach verwendeter KI und Modell beinhaltet das Prompt Engineering eine einzelne Eingabe (Completion) oder eine Eingabesequenz, die wie ein Dialog im Chatbot funktioniert.

Im Completion Mode können Eingaben vervollständigt werden, das heißt, die Texteingabe des Nutzers bzw. der Nutzerin wird erweitert, ergänzt und damit abgeschlossen, so dass ein in sich schlüssiger vollständiger Text auf Basis der Aufgabenstellung generiert wird.

Der Chat Modus ist eher wie ein Gespräch zu betrachten, bei dem – wie auch in einer Unterhaltung – die vorher genannten Antworten zugrunde gelegt werden und als Kontext verwendet werden können. Diese sind dann implizit in den weiteren Antworten vorhanden.

Ein wesentlicher einschränkender Faktor für das Prompt Engineering ist die maximale Länge des Prompts. So ist es z.B. derzeit nicht möglich, ein gesamtes Buch in das Prompt zu integrieren, da der Text zu lang wäre. Gängige Längen sind je nach Modell 2048, 4096, 8196 Tokens oder ca. 500, 1000 oder 2000 Wörter.

Aber auch die Entwicklung weiterer Tools mit der Möglichkeit, längere Texteingaben zu verarbeiten und zur Generierung von Ergebnissen zu nutzen, schreitet sehr zügig voran.

Zur Lösung von Problemen, die längere Texte verarbeiten sollen, kann das Prompt aufgeteilt werden. Weitere Techniken im Rahmen des Prompt Engineering sind Embeddings, Finetuning oder das Trainieren eines angepassten Modells, die hier jedoch nicht weiter erläutert werden sollen.

Im Folgenden sehen wir uns die verschiedenen Stufen des Prompt Engineerings an.

Prompt Basics

Zunächst sei noch einmal erwähnt, dass es sich bei Prompts um natürliche Sprache handelt. Einige Ansätze scheinen daher auf dem ersten Anblick trivial. Dennoch ist zu erwähnen, dass eine KI nicht wie der Mensch funktioniert, der allein aufgrund des Kontexts, Umfeld und des impliziten Wissens die Fragen automatisch um nicht explizite Informationen ergänzt und die Fragen im Gesamtbezug beantwortet.

All das kann die KI nicht aus dem Prompt herauslesen. Es ist daher notwendig, Prompts so genau wie möglich zu beschreiben und Rahmenbedingungen zu erwähnen, die einem wichtig sind. Eine KI hat für sich gesehen keine Intelligenz und keine Empathie, sondern basiert auf Sprachmodellen. Sie versucht, immer zu antworten, auch wenn die Antwort in unseren Augen keinen Sinn ergibt.

Hier eine kleine Veranschaulichung: “THIS “EXACT INSTRUCTIONS CHALLENGE” IS SO HILARIOUS”.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenZu den Basics für gutes Prompting gehören die folgenden einfachen Regeln, die man sich am besten am Beispiel eines Architekten- oder Agentur-Briefings vorstellen kann:

- Klarheit und Wortwahl: Die Verwendung der richtigen Wörter im richtigen Kontext.

- Kontext: Welche Informationen braucht die KI im Kontext.

- Explizit: Klar schreiben, was das erwartete Ergebnis sein soll.

- Antworten ausschließen: Was möchte man nicht haben.

- Länge der Antworten: Wie lange sollen die Antworten sein.

Prompt Templates

Für wiederkehrende Aufgaben eignen sich Prompt Templates, die die oben angeführten Basics verwenden und das Prompt Engineering somit deutlich effizienter gestalten. Diese Templates werden u.a. in der Automatisierung von KI Aufgaben eingesetzt. Einfache (sehr verkürzte) Beispiele hierfür sind:

- “Summarize the following text: [Text Input]”

- “Translate the following text: [Text Input] into [language]”

- “Create a short LinkedIn post for the following blogpost [Post Title], [Post Summary], [Post Url]”

Die Platzhalter in eckigen Klammern werden dabei durch die Automatisierung ersetzt. So können z.B. eingehende E-Mails automatisiert verarbeitet werden oder für neue Einträge in Tabellen bzw. Drittsysteme Texte erstellt werden.

Auch für komplexere Aufgaben sind Templates für Prompts für viele verschiedene Unternehmensbereiche denkbar. Es ist denkbar, dass sich viele Berufsbilder dahingehend entwickeln, dass die Generierung von Templates im Rahmen des Prompt Engineering eine zentrale Rolle erhält:

- Im Tourismus-Umfeld: “Erstelle eine Reiseroute für eine zweitägige Reise nach [Stadt]: welche Orte sollte man besuchen und welche Speisen sollte man von morgens bis abends probieren, und geben Sie mir das Gesamtbudget. Stadt: [hier einfügen]”

- Im Marketing: “Entwickle Ideen, wie E-Mail-Marketing für [Unternehmen] eingesetzt werden kann, um bestehende Kunden zu binden und Wiederholungskäufe von [Produktlinie] zu fördern. Unternehmen = [hier einfügen] Produktlinie = [hier einfügen]”

- In der Produktentwicklung: “Erstelle Vorschläge, wie ich den Funktionsumfang von [Produkt/Dienstleistung] steigern kann, um die Kundenbindung zu erhöhen. Gib präzise Ideen und Schritt-für-Schritt-Anleitungen, um einzigartig zu bleiben.”

Beispiele im Prompt

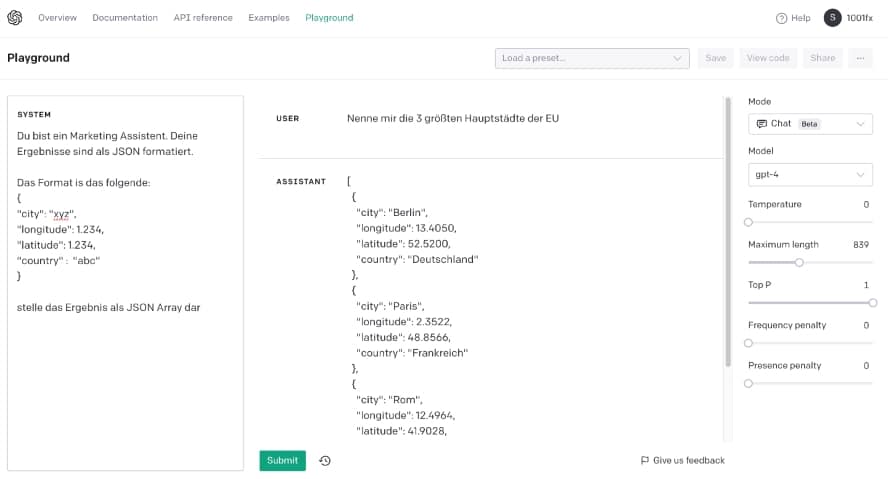

Man kann der Künstlichen Intelligenz durch Beispiele im Prompt mitteilen, wie sie arbeiten soll und wie die Ergebnisse aussehen sollen. Der Vorteil der Beispiele ist dabei, dass die Algorithmen der Künstlichen Intelligenz zum einen die Anforderungen besser “versteht” und die Ergebnisse zum anderen eher dem gewünschten Output entsprechen.

Folgendes Beispiel zeigt, wie sich Ergebnisse auch im JSON Format gestalten lassen:

Aber Achtung, die Rückgabe eines Prompt ist für eine Natural Language Processing (NLP) KI nicht deterministisch. Soll heißen, es ist nicht sichergestellt, dass das Ergebnis für jede Anfrage das gleiche Resultat liefert. Möchte man eine bestimmte Rückgabe garantieren, ist der Weg über Functions (openai.com) oder Plugins ein gangbarer Weg (openai.com).

System Nachrichten für Prompts

Die System-Nachricht ist ebenfalls ein Prompt. Mit diesem Prompt sagt man der KI, wie sie sich verhalten soll. Sie bilden daher eine Art Rahmen oder Restriktionen für das Prompt Engineering.

Die einfachsten Anweisungen können z.B. Framing sein:

- Du bist eine hilfreiche KI, die Texte für Linkend schreibt.

- Du antwortest nur auf Spanisch.

- Deine Antworten sind so, dass ein 10-Jähriger sie versteht.

- Beende jede Antwort mit einem passenden Emoji.

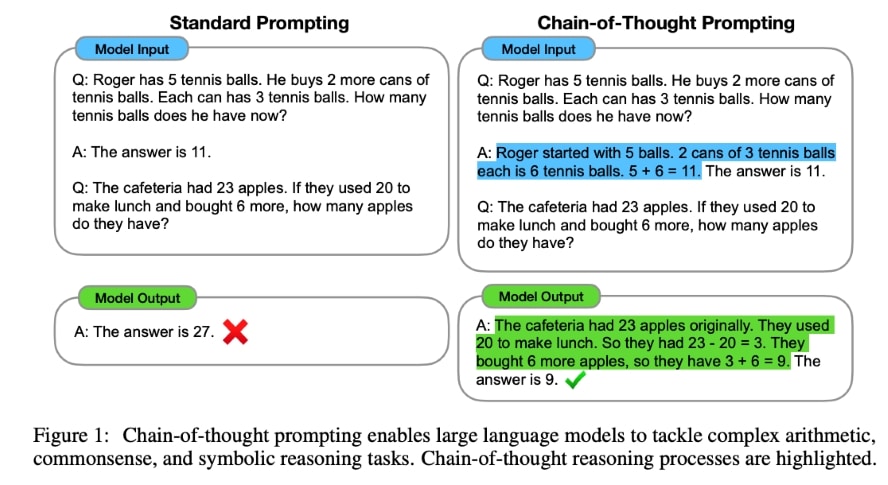

Chain of Thoughts

Die Ausgabequalität eines Prompts lässt sich über sogenannte “Chain of Thoughts” (häufig mit CoT abgekürzt) verbessern. Forscher:innen haben gezeigt, dass, wenn man der KI sagt, dass sie Schritt-für-Schritt denken und das Ergebnis in Bezug zur Aufgabenstellung setzen soll, das Ergebnis besser gegenüber dem Standard Prompt ist (siehe arxiv.org).

(Quelle: arxiv.org)

Die Verbesserung können beeindruckend sein:

| No. | Category | Zero-shot Chain-of-Thought (CoT) Trigger Prompt | Accuracy |

|

1 |

Automatic Prompt Engineer | Let’s work this out in a step by step way to be sure we have the right answer. |

82.0 |

|

2 |

Human- Designed |

Let’s think step by step. (*1) |

78.7 |

| 3 | First, (*2) | 77.3 | |

| 4 | Let’s think about this logically. | 74.5 | |

| 5 | Let’s solve this problem by splitting it into steps. (*3) | 72.2 | |

| 6 | Let’s be realistic and think step by step | 70.8 | |

| 7 | Let’s think like a detective step by step. | 70.3 | |

| 8 | Let’s think | 57.5 | |

| 9 | Before we dive into the answer, | 55.7 | |

| 10 | The answer is after the proof. | 45.7 | |

| – | (Zero-shot) | 17.7 |

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

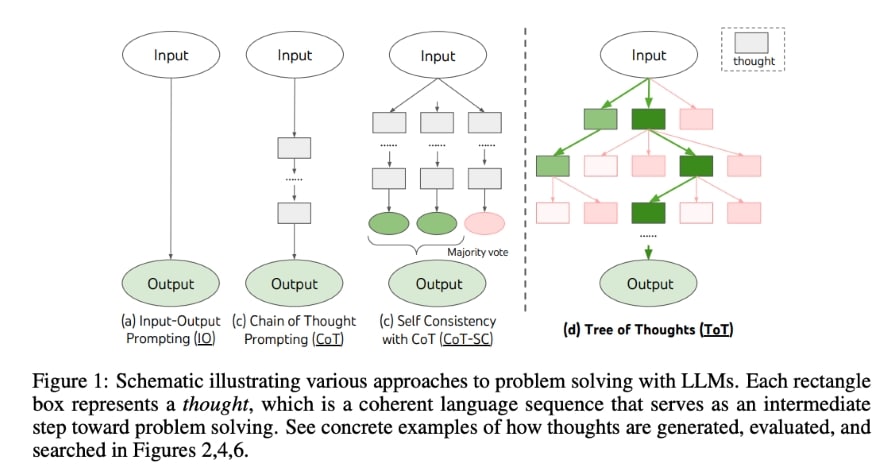

Mehr InformationenDer Vollständigkeit halber sei hier noch der “Tree of Thoughts” (kurz ToT) Mechanismus erwähnt, der noch bessere Ergebnisse erzielen kann. (Quelle: arxiv.org)

(Quelle: arxiv.org)

Erweiterung um eigene Daten

Das Verwenden von ChatGPT oder anderen Systemen der Künstlichen Intelligenz bedeutet in der Regel, dass, wie eingangs erwähnt, die zugrundeliegenden Modelle mit Daten und Informationen trainiert wurden, die allgemein zugänglich sind, wie Webseiten, Bücher, Wikipedia-Einträge.

Um noch bessere Ergebnisse bei der Verwendung der KI zu erzielen, wäre es hilfreich, wenn eigene Daten aus dem Unternehmen, die die Strategie widerspiegeln oder Kundenpräferenzen enthalten sowie Produktdetails zugrunde legen, verwendet werden könnten, um auf das eigene Unternehmen zugeschnittene Ergebnisse zu liefern.

Bei der Eingabe dieser Daten als Informationen im Prompt sind ggf. datenschutzrechtliche Aspekte zu berücksichtigen, da diese Informationen meist vertraulich gehalten werden sollen. Eine einfache Möglichkeit, die Daten der KI bereitzustellen, besteht in der Hinzunahme der relevanten Texte in das Prompt, was aber zu Problemen hinsichtlich der maximalen Tokens führen kann.

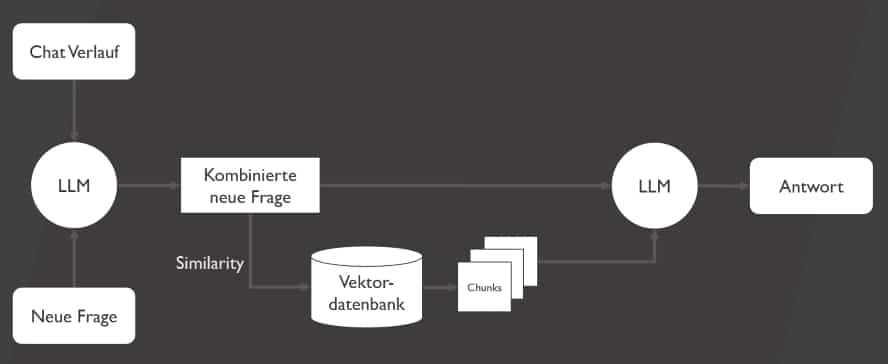

Eine weitere Möglichkeit besteht darin, eine eigene Datenbasis auf der Grundlage interner Daten in Dokumenten oder Datenbanken aufzubauen. Dabei werden die Daten als sogenannte Embeddings übersetzt und in einer Vektordatenbank verfügbar gemacht. Diese Datenbank ist nur intern zugänglich und die Abfragen gelangen nicht in externe Hände.

Nun können Abfragen mit “öffentlichen KI-Modellen” mit der internen Vektordatenbank kombiniert werden. Die passenden Vektoren werden dabei über eine Suche aus der Vektordatenbank extrahiert, indem die Anfrage ebenfalls vektorisiert und als Ähnlichkeitssuche gegen die Datenbank ausgeführt wird.

Die sich daraus ergebenden ähnlichen Vektoren werden dann als Zusatzinformationen in die Abfrage an die KI übergeben.

Zusammenfassung

Einfaches Prompting wird in den nächsten Monaten und Jahren zum Standard-Repertoire der Fähigkeiten von Anwendern bzw. Anwenderinnen gehören. Da es sich um natürliche Sprache handelt, ist die Erstellung weit leichter als z.B. Programmierungen.

Trotzdem wird es wichtig werden, dass sich Mitarbeiter Kompetenzen im Prompt Engineering aufbauen, denn je besser die Prompts verwendet werden können, umso effektiver sind die Antworten und damit die Unterstützung durch die KI.

Insbesondere wird der Fokus hier auf die Formulierung der Prompts gelenkt, die dann im Rahmen von System-Nachrichten noch zielgerichteter ausgewertet werden können. Stufenweises Fragen sowie die Ergänzung eigener Daten machen das KI-Modell dann zu einem sehr mächtigen Hilfsmittel für alle Unternehmensbereiche. Das Nutzen von Templates für wiederkehrende Abfragen spart den Mitarbeitern bzw. Mitarbeiterinnen noch einmal zusätzlich Zeit.

Des Weiteren werden die verschiedenen Tools und Anbieter geeignete Oberflächen bereitstellen und “unter der Haube” automatisch Kontextinformationen in die Prompts einfließen lassen – im Sinne von “den bzw. die Anwender:in besser verstehen”.

Prompt-Engineering – also Spezialwissen über die verwendeten Large Language Models und wie man mit diesen über Prompts reagiert – befindet sich gerade erst am Anfang. Mit dem Erfolg von generativer KI wird die Bedeutung im betrieblichen Umfeld stark zunehmen.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen