Nicht nur in Deinem Alltag passieren Fehler! Denn wenn Du Dich auch schon einmal mit der Suchmaschinenoptimierung auseinandergesetzt hast, weißt Du, wie umfangreich das Thema sein kann und wie schnell Missgeschicke in den Bereichen Technik, Meta, Struktur und Inhalt passieren können.

Als Webmaster oder auch SEO solltest Du neben den fortwährenden Updates ebenso über SEO-Fehler Bescheid wissen, um bei der Performance das Beste aus Deiner Website herauszuholen.

Wenn Du mit Deiner Website also nun mehr Traffic und ein höheres Ranking in der Suchmaschine generieren willst, erfährst Du im folgenden Artikel alles über alltägliche SEO-Anfängerfehler, welche mir bei vielen Websites und Online-Shop immer wieder auffallen.

Duplicate Content

Den Anfang macht der wohl häufigste Fehler: Duplicate Content – also doppelter Inhalt. Dieser entsteht bei gleichem Inhalt innerhalb einer Domain. Hast Du schon einmal angefangen, Content zu produzieren und Dich gefragt, ob der Inhalt Deiner Website einer anderen ähnlich sein könnte bzw. sogar nahezu identisch ist? Nein? Genau das solltest Du Dich aber fragen und immer prüfen.

Erkennt die Suchmaschine, dass Dein Content einer oder mehreren Seiten gleicht, werden diese abgestraft und Du wirst im Ranking zurückgesetzt. Dabei wird hier zwischen internem (duplizierte Passagen der eigenen Website) und externem Duplicate Content (Duplikate auf fremden Websites) unterschieden.

Du solltest somit in jedem Fall meiden, Sätze oder komplette Passagen von anderen Websites zu kopieren – egal, ob es sich um die Konkurrenz handelt oder nicht.

Glaube mir, das zu beachten, wird sich lohnen und auf hat eine positive Wirkung auf die Suchergebnisse. Zudem werden viele Seiten mit verschiedenen URLs, z. B. ,,www“ oder ,,non-www“ erreichbar sein. Google erkennt diese als duplizierte Version an, wählt eine der URLs aus und crawlt diese, daher solltest Du schauen, dass Deine Domains richtig umleiten.

Ein weiterer Indikator für Duplicate Content ist der sogenannte „Trailing Slash.“ Das ist der Schrägstrich am Ende Deiner URL. Dieser ist für URLs von konkreten Seiten und Dateien von Bedeutung, da er zwei einzelne, aber kongruente Seiten erzeugen kann.

Da sich dies ebenfalls auf Deine Suchmaschinenoptimierung auswirken kann, solltest Du diesen Fehler auf jeden Fall umgehen. Meistens kannst Du dieses Serverseitig oder per .htaccess lösen.

Weiterhin kannst Du auch Duplicate Content mit folgenden Dingen generieren:

- URLs, die über Groß- und Kleinschreibung erreichbar sind und nicht umleiten

- Tag-Seiten, Schlagwort-Seiten in Blogs

- URLs mit Parametern für die Sortierung und Darstellung von Produktübersichtsseiten

Die Liste von Möglichkeiten lässt sich auch noch weiter Ausführen. Aber das sind die gängigsten die Deinen Inhalt dupliziert darstellen.

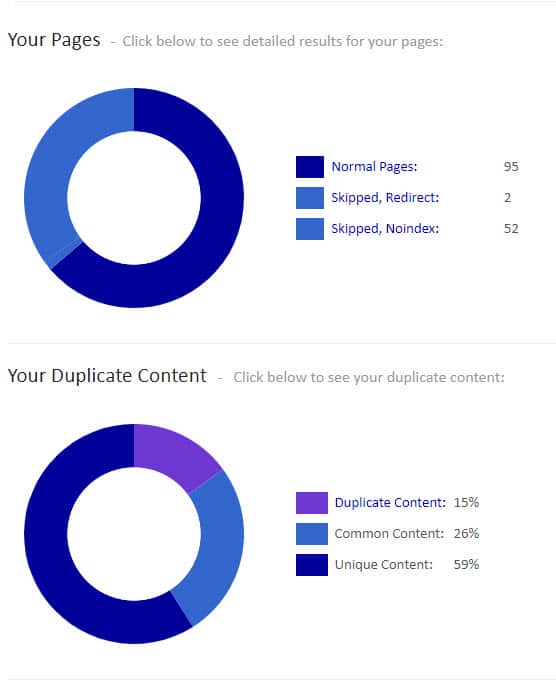

Oft kannst Du Deine Dopplungen mit Drittanbieter Tools wie “seobility” oder “siteliner” prüfen.

Eine Analyse Deine Webseite mit Drittanbieter-Tools gibt Dir schnell Aufschluss über Deinen Inhalt.

Hidden Content

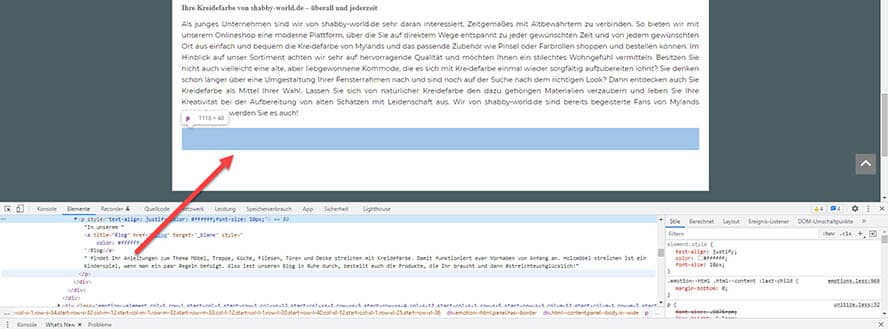

Einer der größten Fehler, die Du unbedingt vermeiden solltest, ist Hidden Content – also versteckte Textpassagen zu platzieren, die der Nutzer vor dem Bildschirm nicht sehen kann, welchen Suchmaschinen-Crawler aber identifizieren können. Hier tricksen Webmaster/Nutzer gerne, indem sie weiß geschriebene Textpassagen auf weißen Hintergrund legen und die Schriftgröße aufs Minimum reduzieren.

Früher wurde diese Methode gerne verwendet, um relevante Haupt-Keywords auf einer Seite unterzubringen, ohne die Benutzerfreundlichkeit für den Besucher einzuschränken, aber im Suchmaschinenranking zu punkten. Bei dieser Methode wirst Du allerdings schnell merken, dass eine Abstrafung nicht weit entfernt ist und Deine Seite gesperrt wird.

So würde ein Hidden Content auf der Seite aussehen. Du kannst ihn als Besucher zwar nicht sehen aber der Crawler.

Eine andere Form ist das Einfügen von versteckten Backlinks / Verlinkungen, die für Website-Besucher ebenfalls unsichtbar sind. Backlinks sind Links von einer anderen Domain, welche auf Deine eigene Website führen – sie bilden den Kern des hiesigen Webs. Aber dennoch wirst Du bei dieser Form schneller bestraft, als Du schauen kannst.

Wenig und schlecht aufbereiteter Content

Ebenso schlimm wie doppelter ist schlechter Content als Anfänger! Denn wie heißt das Sprichwort so schön: „Content ist King.“ Er ist einer der wichtigsten Bestandteile im Onpage SEO, um eine gute Sichtbarkeit bei Suchmaschinen zu erzielen. Content sollte relevant sein und Deinem Nutzer einen Mehrwert bringen. Denn sind wir mal ehrlich, niemand liest sich langweilige Texte bis zum Ende durch, oder?

Guter Content ist in den letzten Jahren ein sehr wichtiger Bestandteil bei gutem Ranking einer Website geworden. Qualitativ schlechte, bedeutungslose, kopierte oder gestohlene Texte wirken sich demnach schlecht auf das Suchmaschinenranking. Aber das inhaltliche bringt nicht nur einen Vorteil für die Suchmaschinenoptimierung, sondern lohnt sich auch deshalb, da die User Deine Website mit Sicherheit nicht nur einmal besuchen werden.

Genauso wichtig wie gute Texte sind Bilder und Videos, die Du auf Deiner Webseite unbedingt mit einbauen solltest. Achte ebenfalls darauf, dass diese gut strukturiert sind und baue Absätze sowie verschiedene Über- und Unterüberschriften ein. Der nächste Punkt, den Du beachten solltest, um Probleme zu vermeiden, ist die Länge Deiner Textpassagen.

Bei zu langen Passagen kann es sein, dass die Seite nicht eingeordnet werden kann. Achte auf eine Keyworddichte von ca. 0,5 – 2 %. In diesem Kontext nutze ich gerne “seorch.”

Du kannst Deine Keyworddichte auch mit folgender Formel berechnen:

(100 ÷ Gesamtwortanzahl) x Anzahl des Main Keywords im Text = 0,5 – 2 % (wäre der Idealfall)

Auch zu kurze Texte sollten auf Deiner Webseite vermieden werden, da diese Deinem Websitebesucher keinen guten Mehrwert bieten können. Dass der Punkt Rechtschreibung und Grammatik ebenfalls dazugehört und unumgänglich ist, brauche ich eigentlich nicht erwähnen.

Der letzte Aspekt ist die ,,uniqueness.“ Deine Webseiten Texte sollten, wie bereits erwähnt, niemals einfach kopiert und übernommen werden. Hier kannst Du mit einer direkten Abstrafung rechnen. Vermeide es also lieber und entwerfe eigene einzigartige Texte mit passenden Bildern zum Inhalt.

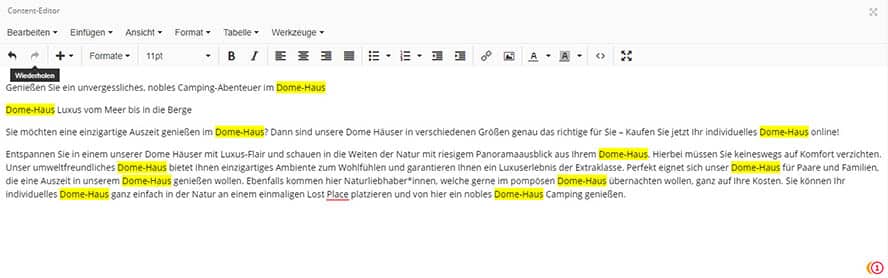

Keyword Stuffing

Beim Keyword Stuffing verwenden Website-Besitzer eine unverhältnismäßig große Anzahl an so genannten Schlüsselwörtern oder auch Stichwörtern in ihren Texten, um das Suchmaschinenranking zu verbessern. Ein fataler Fehler, welchen auch Du als Anfänger unbedingt vermeiden solltest, wenn Du ein gutes Ranking erzielen möchtest. Das Keyword Stuffing führt zu Seiten, die kein Mensch mehr lesen kann – eine (zu) hohe Keyword-Dichte ist hier vorprogrammiert, die Suchmaschine bewertet dies als Spammaßnahme.

Früher wurde das Stuffing oft genutzt, um Websites in den SERPs höher ranken zu lassen – heute allerdings handelt es sich um eine nervige Spam-Technik. Was früher funktionierte, ist heute überholt. Das Keyword Stuffing gilt als allgemeine Black-Hat-SEO-Praxis und wird von Google umgehend abgestraft.

Das gute ist allerdings, dass die meisten Onpage-Optimierungs-Tools dieses Missgeschick verhindern bzw. korrigieren.

Mit zu vielen Keywords ist der Text nicht mehr lesbar.

Fehlende META

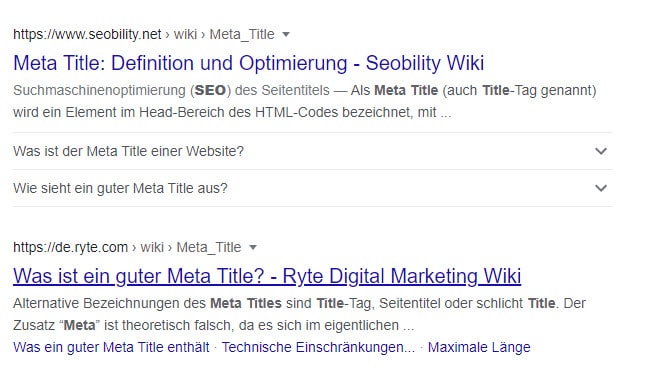

1. Fehlender Title

Meta Titles (oder auch Title-Tags genannt), sind Elemente, die als Seitentitel für eine jeweilige Website angezeigt und festgelegt werden. Wenn Du bestmögliche Title Tags verwendest, werden die Keywords in klickwürdige Linktexte für die SERPs umgewandelt.

Sie geben Deinem zukünftigen Besucher einen kleinen Vorgeschmack auf die Website und erhöhen die Klickrate. Überdies solltest Du die Suchintentionen des Nutzers nachvollziehen können, um auf Deine Webseite aufmerksam zu machen.

Seitentitel sind ein Rankingfaktor und essenziell, wenn es darum geht, bedeutsame Informationen zu platzieren. Keywordspam sollte allerdings vermieden und versucht werden, mit aussagekräftigen Schlagworten auf Deine Website aufmerksam zu machen und die Sichtbarkeit zu erhöhen.

Vergisst Du den Seitentitel, wird Google sich aus den anderen in Deinem Artikel Überschriften einen Title für die SERPs generieren.

Achte darauf, dass Du neben den interessanten Keywords auch keine zu langen Title erstellst. Sie sollten zwischen 55 und 65 Zeichen, max. 70 Zeichen, lang sein – inklusive Leerzeichen! Sind Deine Title Tags länger, werden diese abgeschnitten und Du musst mit einer Abstrafung in puncto Sichtbarkeit rechnen.

Ich nutze zur Überprüfung der Metas gerne das Online Tool von “claneo” oder den SERP Snippet Generator von “Sistrix.” Dieser zeigt in einer Vorschau, wie die Metas auf Desktop und Mobilgeräten aussehen.

Meta-Title mit der richtigen länge und den passenden Keywords.

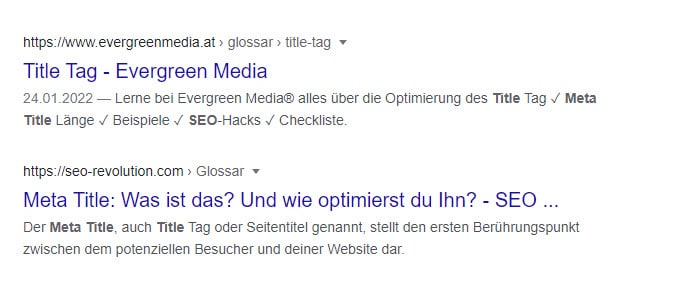

2. Fehlende Description

Ähnlich wie beim Meta-Title gibt die Meta-Description eine kurze Beschreibung dessen an, auf das sich Deine Website bezieht. Die Description hilft Dir dabei, Dich von Mitbewerbern abzugrenzen. Wähle diese also ebenfalls gewissenhaft aus und lockere sie mit Haken und Pfeilen auf. Achte hier bitte darauf, 160 Zeichen nicht zu überschreiten! Je interessanter Du die Description wählst, desto mehr Traffic erlangst Du auf der Website.

Allerdings sollte erwähnt werden, dass die Description im Onpage SEO unrelevant für Dein Suchmaschinenranking ist. Der Grund dafür ist, dass viele Webmaster die Description mit dem Keyword Stuffing überhäuften und es so keinen Mehrwert mehr für die Nutzenden bot. Google entschied somit im Jahre 2009, die Description bei der Sichtbarkeit auszuschließen. Dennoch sollte Dir bewusst sein, dass die Seitenbeschreibung einen erheblichen Einfluss auf die CTR (Click-Trough-Rate) hat. Diese gibt nämlich an, wie viele Nutzer, nach dem sie nach bestimmten Schlagwörtern gesucht haben, wirklich auf Deine Seite klicken.

Die Meta-Description sollte ansprechend gestaltet sein und zum Klicken auffordern.

3. Fehlende Robots

Robots sind Textdateien (Robots.txt), die dem Crawler Anweisungen für die Suchmaschine geben. Hier legst Du fest, welche Inhalte der Crawler durchsuchen darf und welche nicht –Du kannst also steuern, wie sich die Textdateien im SEO verhalten. Starkes einschränken der User Agents bewirkt allerdings eher, dass Du eine schlechte Sichtbarkeit erzielst.

Also können Websites, welche ausgeschlossen wurden, natürlich nicht ranken. Ebenfalls wirkt es sich negativ auf die Sichtbarkeit aus, wenn es kaum Einschränkungen gibt. Hier könnten URLs mit Duplicate Content indexiert werden.

In den häufigsten Fällen ist sie jedoch einfach leer, dabei könnte man hier noch zusätzlich die Sitemap verlinken.

Hinterlegt wird die Datei im Root-Verzeichnis der Domain. Es ist wichtig, dass Du die Robot.txt als UFT-8- oder ASCII-Textdatei im Stammverzeichnis Deiner Website erstellst.

Die Textdatei ist eine wertvolle Technik, die von jedem Webmaster oder SEO-Experten (oder alle die es noch werden wollen) genutzt wird.

Crawlbarkeit

Wo Du nun schon einiges über die Crawlbarkeit gelesen hast, möchte ich dieses Thema ebenfalls bei in puncto SEO-Fehler aufgreifen. Die Crawlbarkeit hat direkten Einfluss darauf, gute Rankings in den SERPs zu erzielen. Der Crawler durchforstet das Internet und überprüft dessen Inhalte.

Enthält Deine Seite also ausgezeichneten Inhalt, ist eine gute Sichtbarkeit sehr wahrscheinlich. Wenn es aber bereits technische Probleme gibt und die Seite nicht gecrawlt werden kann, ist diese für Google wahrscheinlich nicht sichtbar.

Es könnten folgende Probleme auftreten:

- Defekte interne Bilder

- Defekte interne Links

- URLs enthalten Unterstriche

- Nofollow-Attribute in ausgehenden externen Links

- Seiten mit nur einem internen Link

- Vorübergehende Weiterleitungen

Um die Arbeit für den Crawler zu unterstützen sind XML- oder HTML-Sitemaps eine gute Lösung. Diese enthalten eine vollständige Linkstruktur Deiner Website – so kann die Suchmaschine Deine Unterseiten einfach finden und indizieren.

Fehlende oder falsche Canonical Tags bzw. Canonical Links

Ein Canonical Link (oder auch Canonical Tag, Canonical URL oder URL Canonicalization) wird im Quellcode einer Webseite eingefügt und gibt die konkrete URL zum Kontext Deiner Seite an. Man verwendet ihn, wenn mehrere Seiten mit unterschiedlichen URLs einen fast identischen Inhalt aufweisen.

Dies ist z. B. der Fall, wenn:

- eine Website mit und ohne “www” aufrufbar ist

- eine Website sowohl über “http” als auch “https” aufrufbar ist

- der Inhalt einer Webseite über mehrere Versionen / URLs aufrufbar ist

Google wird durch den Canonical Link gezeigt, welche URL die Originale ist und in den Suchergebnissen angezeigt werden sollte. Verwende also unbedingt Canonical Links, um Dopplungen vorzubeugen.

Mangelhafte interne und externe Verlinkung

Damit die Crawler Deine internen Seiten so gut wie möglich indexieren können, sollten diese möglichst miteinander verlinkt sein. Links sind ein wichtiger Bestandteil und ein Rankingfaktor für Deine Website. Sie zeigen, welche Seite Deiner Website am wichtigsten ist – nämlich die, die am häufigsten verlinkt ist.

Neben der SEO-Relevanz ist dies auch für die Nutzerfreundlichkeit maßgebend. Sie helfen dem Websitebenutzer dabei, sich besser auf anderen Seiten zurecht zu finden und erhalten passende Informationen zu einem wichtigen Thema.

Eine ebenso wichtige Rolle spielen externen Links, welche im Offpage SEO von wichtiger Bedeutung sind und von fremden Websites auf Deine Seite führen. Wenn Du berücksichtigst, dass relevante Schlüsselwörter im Ankertext von Backlinks enthalten sind, erzielst Du damit ebenfalls positive Effekte. Gestalte die Ankertexte für User möglichst interessant, um eine hohe Klickrate zu erzielen.

Wenn Du Seiten mit vielen internen Links hast, solltest Du dies korrigieren und als HTML-Sitemap mit dem Robots-Attribut „noindex“ versehen. Wenn Deine Seite eine Anzahl von ca. 400 Links besitzt, könnte es sein, dass die Suchmaschine den Links nicht mehr auf alle Seiten folgen kann.

Ich kann Dir ebenfalls empfehlen auf „Soiling“ (themenrelevante Verlinkung) zu achten. Wenn ein Webseitenbesucher in Deinem Online-Shop also beispielsweise eine Suchintention nach Taschen hat, sollten ihm keine Links von Schuhen oder Jacken angezeigt werden.

Fehlerhafte Weiterleitung mit 301 oder 302 Statuscode

Der nächste SEO-Fehler dreht sich um die HTTP-Weiterleitungen (Redirects). Weiterleitungen werden immer dann benötigt, wenn Du Inhalte – wie zum Beispiel eine Änderung der URL-Struktur – hast oder sogar Inhalte, die von Dir gelöscht wurden. Da bei einer 302 Weiterleitung die alte Adresse gültig bleibt, sollte diese korrigiert werden. Die ursprüngliche Adresse bleibt im Index der Suchmaschine und wird auch weiterhin geprüft.

Wenn Du mit dem Statuscode 302 weiterleitest, solltest Du dies möglichst nur für zweitweise Anwendungen tun. Für eine dauerhafte Weiterleiterleitung, wie z. B. im Falle eines Domainumzuges oder Umbenennung der URL, solltest Du den Statuscode 301 anwenden.

Warum der Status-Code nun wichtig für SEO ist und vermieden werden sollte? Ganz einfach: Nicht erreichbare Seiten geben ohne Redirect einen 404 Error aus. Das führt dazu, dass die Absprungrate auf Deiner Seite steigt und Du mit der Zeit aus den Suchergebnissen entfernt wirst.

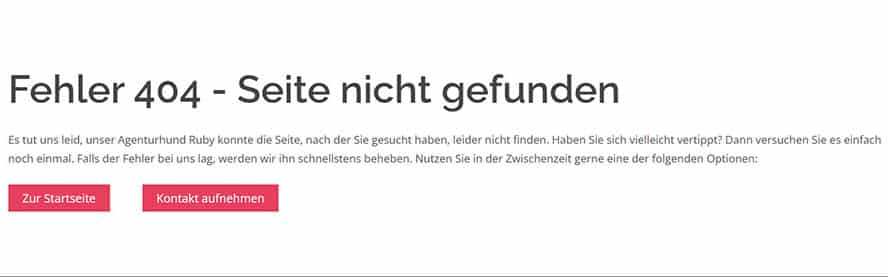

Zu hohe Anzahl an 404-Fehlern

Dieser SEO-Fehler bedeutet, dass Deinem Besucher zur angegebenen URL keine Seite angezeigt werden kann, da diese nicht verfügbar ist. Er taucht meist auf, wenn der User eine falsche URL eingegeben hat oder die Seite entfernt bzw. nicht umgeleitet wurde. Oft sorgt diese Inkorrektheit für eine hohe Absprungrate des Users bzw. potenziellen Kunden und sollte gänzlich vermieden werden.

Wenn Du allerdings zu viele Error Seiten hast, wirkt sich dies negativ auf Deine Positionierung aus. Für Google bedeutet dies eine unzureichende Aufrechterhaltung Deiner Website. In diesem Fall solltest Du diese mit einer 301 Weiterleitung ausbessern – und was das ist, hast Du ja bereits erfahren.

Lege Deinen 301 Statuscode am besten auf einen guten internen Link, der auch eine Relevanz zur Umleitung aufweist, um die Linkkraft der Links nicht zu verschwenden und das Suchmaschinen Ranking nicht zu beeinflussen.

Leite Deine 404-Fehler immer auf relevant passende Inhalte um, damit der Traffic nicht einbricht.

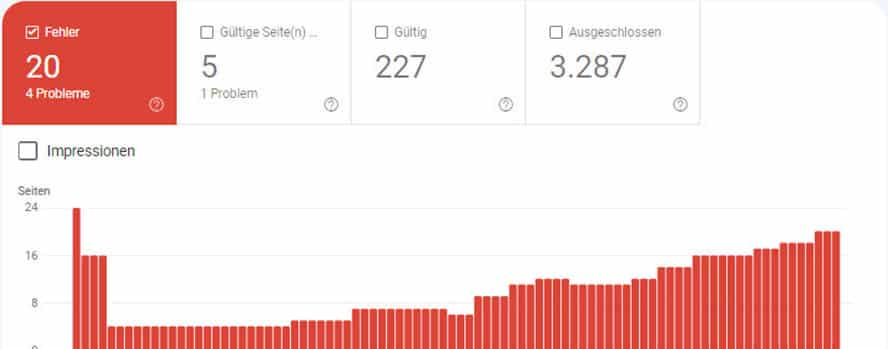

Kleiner Tipp: Schau in die Search Console von Google. Denn dort hast Du einen Einblick auf die Abdeckung Deiner Website und bekommst hier Unstimmigkeiten sowie Warnungen angezeigt.

Die Search Console gibt Dir Aufschluss über den Zustand Deiner Seite.

Fehlende Sitemap XML

Beim letzten Punkt der häufigsten SEO-Fehler geht es um XML-Sitemaps. Diese sind günstig für das Crawlen Deiner Seite. Sie können in der Search Console hochgeladen werden, wodurch Du der Suchmaschine einen Überblick über alle URLs verschaffst, welche auf Deiner Website vorhanden sind.

Am meisten lohnt es sich, die XML-Sitemap einzupflegen, wenn neue Websites noch keine oder nur wenige Backlinks besitzen. Die Sitemap kann helfen, dass alle Unterseiten schneller indexiert werden. Oftmals entscheiden die Algorithmen aufgrund der XML-Sitemap, ob Deine Website gecrawlt oder indexiert wird.

Die Sitemap kannst Du unter dem Dateinamen „sitemap.xml“ im Root-Verzeichnis Deiner Webseite anlegen oder unter WordPress mit „wp-sitemap.xml“ (Hauseigene Sitemap von WordPress) beziehungsweise „sitemap_index.xml“ (Yoast oder RankMath) einsehen. Ich möchte allerdings keine Garantie ausschreiben, dass hierdurch die Sichtbarkeit erhöht wird. Es ist lediglich wahrscheinlicher, dass schwach verlinkte Inhalte von Google schneller gefunden werden.

Fazit

Eine gute SEO ist das A und O im Marketing-Dschungel. Durch meine Erfahrung als SEO weiß ich, worauf es bei der Optimierung ankommt und welche SEO-Anfängerfehler vermieden und korrigiert werden sollten. In meinem Artikel habe ich nur die häufigsten Fehler aufgelistet, es gibt allerdings noch einige mehr, etwa die Ladezeit einer Webseite oder die Bilder-Optimierung.

Mein Tipp: Halte Deine Website stets aktuell und stelle interessante sowie relevante Themen bereit – auch die technische Struktur solltest Du nicht außer Acht lassen. Achte auf passende METAs, entferne tote Links oder fehlerhafte interne / externe Weiterleitungen. Behalte die Google Search Console von Google im Auge und bereinige Fehler und Warnungen.

Wenn Du die Punkte beherzigst, sollten sich Deine Sichtbarkeit und Deine Rankings um einiges verbessern.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen