Was ist Big Data?

Die Einkaufsliste ist auf dem iPhone, bezahlt wird mit der Kreditkarte und die iWatch zählt nebenbei die verbrauchten Kalorien. Gleichzeitig telefoniere ich mit meiner Mutter. Im Supermarkt wird das vegane Schnitzel mit einem „piep“ gescannt und als verkauft gekennzeichnet. Ich bekomme einen Kassenzettel mit den Einkäufen und im Hintergrund wird die Warenwirtschaft aktualisiert. Es ist Samstag 18:23 Uhr. In den nächsten 34 Minuten werden 30 weitere Packungen der veganen Schnitzel verkauft. Mittwoch zur gleichen Zeit waren es 12 Packungen.

In jeder Sekunde werden mehr Daten produziert, als unser Gehirn sich vorstellen kann. Im Jahr 2006 gab es weltweit 2,5 Zettabyte Daten. Im Jahr 2018 waren es 33 und bis 2025 sind 175 Zettabyte prognostiziert. Ein Zettabyte ist eine 1 mit 21 nullen. Einen echten Vergleich zu finden, um diese Menge in Relation zu stellen, scheint fast unmöglich.

Mark Liberman hat im Jahr 2003 errechnet, dass alle zwischen dem Jahr 1800 und 2000 gesprochenen Worte der Menschheit 42 Zettabyte an Daten produziert haben. Alle laut ausgesprochenen Worte weltweit.

Big Data ist mehr als ein Buzzword. Obwohl Big Date erst in den letzten Jahren immer bekannt wird, gibt es diese Art von Datenanalysen schon lange. Jeder Konzern nutzt Big Data, um bestimmte Informationen über das eigene Unternehmen zu bekommen.

Business Intelligence oder Data Warehouse wurde das früher in der IT genannt. Und je das Datenvolumen wird, je komplexer werden auch die Analysen. Big Data ist heutzutage schon häufig im Einsatz, ohne dass wir das bewusst wahrnehmen. Denn ohne Big Data gäbe es auch kein Online-Marketing.

Die Bitkom definiert Big Data als:

„Die wirtschaftlich sinnvolle Gewinnung und Nutzung entscheidungsrelevanter Erkenntnisse aus qualitativ vielfältigen und unterschiedlich strukturierten Informationen, die einem schnellen Wandel unterliegen und in bisher ungekanntem Umfang zu Verfügung stehen.”

Auf die Größe des Datentopfes kommt es in der Realität allerdings nicht. Du kennst sicherlich auch die Kiste mit alten CDs, Ordnern und einem Legoauto, die Du in jedem Umzug vom einen in den anderen Keller mitnimmst.

Circa 80 % aller Daten sind unstrukturiert und nicht verwertbar. Wie beispielsweise ein YouTube Video oder ein Blogeintrag. Strukturiert hingegen ist der Klick einer Person auf den Button „Jetzt zum Einkaufskorb“, der Deinen Facebook Pixel auslöst. Sie liegen meist in einer Datenbank und haben eine Relation zu anderen Daten. Also eine Beziehung oder Verknüpfung.

Unstrukturierte Daten sind also für Maschinen aufwendig zu interpretieren. Sie haben zusätzlich meist ein hohes Datenvolumen. Für solche Daten gibt es beispielsweise Algorithmen für Bilderkennung. Diese generieren im Big Data dann Metadaten aus den unstrukturierten Daten. Metadaten werden auch als Daten über Daten bezeichnet. Strukturierte Daten hingegen haben häufig schon direkt eine maschinenlesbare Struktur.

Die Qualität der Daten und der Datenquellen ist entscheidend und die Erkenntnisse, die wir daraus gewinnen können. Jede Online-Marketingkampagne hat das Ziel wirtschaftlich sinnvoll zu sein. Wenn Du weißt, wie viele Kunden auf Deine Website kommen und wie viele davon Dein Produkt kaufen, kannst Du auf Basis dieser Informationen Entscheidungen treffen. Dabei verändert sich das Klick- und Kaufverhalten kontinuierlich und unerwartet.

Der Begriff Big Data steht im direkten Zusammenhang mit Data Analytics – der Analyse und Auswertung der Daten. Hierfür ist die Masse der Daten zweitrangig, die Qualität entscheidet. Jeder Online-Marketer sollte sich immer bewusst machen, welche Daten er sammeln und verarbeiten möchte und wo er diese Daten einsammelt. Die schiere Menge führt nicht zwangsläufig zu besseren Entscheidungen. Gezielte Datensammelpunkte, die eine hochwertige Analyse ermöglichen, sind wesentlich effektiver

Das Ziel: Aus den Daten den maximalen Wert (im englischen wird der Begriff Value oder Business Value genutzt) zu generieren.

In den Grundlagen basiert Big Data auf vier Aspekten:

1. Datenmenge (“Volume”)

In der Einleitung haben wir über die gigantische Menge an vorhandenen Daten gesprochen. 175 Zettabyte bis 2025. Das wären 35.000.000.000.000.000 Bilder bei einer Größe von 5 MB. Diese Daten lassen sich ohne Automatisierung und Technologien aus dem Machine Learning nicht bewältigen. Die richtigen Daten zu sammeln ist die Basis für jede hochwertige Auswertung. Zudem braucht es skalierbare Systeme, die diese Massendaten auch verarbeiten können.

Big Data funktioniert durch das hohe Datenvolumen in den meisten Fällen nur durch die Speicherung auf Systemen in der Cloud. Durch den Ausbau des Internets ist Cloud Computing heute jedoch kein Problem mehr und bietet eine Vielzahl an Chancen.

2. Datenvielfalt (“Variety”)

Online-Marketer haben sich mit einer zunehmenden Vielfalt von Datenquellen und Datenformaten auseinanderzusetzen. Aus immer mehr Quellen liegen Daten unterschiedlicher Art vor, die sich in unstrukturierte (z. B. Präsentationen, Texte, Videos, Bilder, Tweets, Blogs), semistrukturierte (z. B. Kommunikation von und zwischen Maschinen) und strukturierte (z. B. von transaktionalen Applikationen wie ein Facebook Pixel) Daten gruppieren lassen. Die Algorithmen von Google, Facebook oder Microsoft verwenden alle Daten.

3. Die Geschwindigkeit (engl. “Velocity”)

Die vorhandenen Datenmengen sollen nun aufbereitet und analysiert werden, dabei steht die Geschwindigkeit der Auswertung im Vordergrund. Moderne Systeme erfassen Daten in Echtzeit. Ein Kunde klickt auf die Werbung und kauft danach. Diese Information wird sofort an Facebook zurückgespielt und die Zielgruppe der Ausspielung der Werbeanzeige angepasst. Die Verarbeitungsgeschwindigkeit sollte mindestens genauso schnell, am besten sogar schneller wachsen als die Datenmenge. Damit sind verschiedene Herausforderungen verbunden, wie zum Beispiel die Analysen großer Datenmengen mit Antworten im Sekundenbereich, Datenverarbeitung in Echtzeit, Datengenerierung und Übertragung in hoher Geschwindigkeit.

4. Analytics

Unter Analytics werden die Methoden zur möglichst automatisierten Erkennung und Nutzung von Mustern, Zusammenhängen und Bedeutungen verstanden. Zum Einsatz kommen u. a. statistische Verfahren, Vorhersagemodelle, Optimierungsalgorithmen, Data-Mining, Text- und Bildanalytik. Das Ziel ist, durch gezielte Analysen die richtigen Geschäftsentscheidungen treffen zu können, um so einen Wettbewerbsvorteil zu erlangen.

5. Datenqualität (engl. “Veracity”)

Ein fünfter und häufig vergessener Aspekt ist die Qualität der Daten. Sie bildet das Fundament jeder Analyse. Es gibt verschiedene Definitionen und Interpretationen für den Begriff Datenqualität.

Eine gängige lautet:

„Datenqualität ist die Gesamtheit der Ausprägungen von Qualitätsmerkmalen eines Datenbestandes bezüglich dessen Eignung, festgelegte und vorausgesetzte Erfordernisse zu erfüllen.”

Wenn Du die Performance einer Werbeanzeige bewerten willst, müssen die Parameter wie Preis per Klick oder Preis pro Kauf immer korrekt sein. Eine schlechte Datenqualität verbrennt schnell Geld, weil Du entsprechend schlechte Entscheidungen treffen kannst. Die Generierung von Datenbeständen ohne die entsprechende Qualität bringt also keinen Wettbewerbsvorteil.

Auch die Wahl der Datenquelle ist entscheidend. Ist der Klick im Werbemanager von Facebook wichtiger oder eher der Nutzer, der auch auf deiner Seite landet? Das kann von Unternehmen zu Unternehmen unterschiedlich sein. Aber die Wahl der richtigen Zahl aus der richtigen Anwendung ist wichtig. Das hat Auswirkungen auf Entscheidungen.

Wie kannst Du Big Data nun nutzen, um Mehrwert im Online-Marketing zu erschaffen?

(Quelle: unsplash.com)

Data-Mining

„Data-Mining ist die automatische Auswertung großer Datenmengen zur Bestimmung bestimmter Regelmäßigkeiten, Gesetzmäßigkeiten und verborgener Zusammenhänge”

Nachdem Du ein schwarzes T-Shirt in den Warenkorb gelegt hast, erscheint die Meldung: „Kunden kauften häufig auch diese schwarze Jeans“. Der echte Wert für jeden Online-Marketingexperten liegt in den Verbindungen zwischen den vorhandenen Daten. Damit die Daten verwertbar werden, braucht es zum einen eine gute Frage, die beantwortet werden soll und zum Zweiten einen guten Algorithmus, der die Frage beantwortet.

Nur dann kannst Du den Daten eine Bedeutung. Jede Anwendung oder jedes System ist nur so gut wie die Methode, die Du nutzt, um an Dein gewünschtes Ergebnis zu kommen.

Die richtige Frage zu kennen und genau zu wissen, wie Dein Verkaufsprozess funktioniert und an welchen Stellen Du Daten sammelst, ist entscheidend für das Ableiten von richtigen Entscheidungen für dein Unternehmen.

Desto mehr Informationen Du dabei über den einzelnen Kunden hast, desto mehr Möglichkeiten zum Testen und Analysieren von Hypothesen bekommst Du. Hier ist das Datenvolumen entscheidend.

Der Begriff Data-Mining kommt nicht von irgendwo her. Du versuchst aus den vorhandenen Daten das „Gold“ abzubauen.

Dabei wird im Data-Mining zwischen beschreibende (deskriptive) und vorhersagende (prädiktive) Algorithmen unterteilt. Beschreiben bedeutet, dass Du innerhalb Deiner Kunden Gemeinsamkeiten erfassen kannst. 80 % der 33-jährigen Männer, die auf Deine Website kommen, kaufen am 13. Februar Blumen.

Der vorhersagende Algorithmus könnte aufgrund einer Einstellung allen 33-jährigen Männern am 12. Februar Werbung für Deine Website ausspielen.

Regelmäßigkeiten und Muster zu erstellen ermöglicht die Definition eines Normalbereichs. Wenn Du jeden Tag eine iWatch trägst, werden Sensordaten aufgezeichnet. Dazu zählen beispielsweise Deine Gesundheitsdaten. Nach 30 Tagen ergibt sich das Muster, dass Dein Ruhepuls bei ca. 63 Schlägen pro Minute liegt. Wenn Dein Puls eine Unregelmäßigkeit aufweist, kann Dir die Uhr durch maschinelle Auswertung den Verdacht auf einen Herzinfarkt melden.

Das Sammeln von Daten ist ohne die Verarbeitung und das Ableiten von Informationen aus unternehmerischer Sicht ohne Vorteil. Der relevanteste Aspekt ist die Frage, welche Frage Du mit der Auswertung beantworten möchtest und wie kannst Du daraus für Deine Geschäftsprozesse oder Geschäftsentscheidungen einen Wettbewerbsvorteil erlangen.

Die Sammlung von Daten bringt auch immer die Verwaltung mit sich. Und diese muss im Sinne der DSGVO passieren. Aus diesem Grund ist eine unnötige Sammlung von Daten nicht zu empfehlen.

Muss es immer voll automatisiert sein?

Immer wenn Du im Online-Marketing tätig bist, nutzt Du automatisch Big Data. Die meisten Aufgaben werden Dir dabei von Unternehmen wie Facebook, Google oder Microsoft abgenommen. Denn jeder Facebook Ad, jeder Besuch auf Deiner Website, der mit Google Analytics getrackt wird und jede YouTube Werbeanzeige, produzieren große Mengen an Daten. Die maschinelle Auswertung wird automatisch im Hintergrund durchgeführt und Du kannst jederzeit darauf zugreifen.

Die Algorithmen sind dabei Unternehmensgeheimnisse der großen Unternehmen. Sie genau zu verstehen hat weniger Relevanz, als genau zu wissen, wo die eigenen Datenmesspunkte sind. Also welchen Button drückt der Kunde beim Kauf auf Deiner Website und wo kannst Du diese Information abrufen.

(Quelle: unsplash.com)

Mit jedem Klick, mit jeder neuen Information lernt der Algorithmus dazu. Diese Technologie wird übergreifend „Machine Learning“ genannt. Die Definition von Big Data besagt, dass die Daten automatisiert interpretiert und verarbeitet werden, weil die Datenmengen zu komplex oder zu schnelllebig sind, um manuell analysiert werden zu können. Big Data ist damit definitionsgemäß immer automatisiert und funktioniert in Kombination mit Machine Learning.

Ohne Big Data gibt es kein Online-Marketing, wie wir es heute verstehen. Die Datenmengen und deren Verarbeitung sind die Basis für jede Entscheidung. Aber wie kannst Du jetzt starten?

Wie Starte ich jetzt? Hypothesen aufstellen und verifizieren

Auf welche Frage suchst Du eine Antwort? Welche Herausforderung in Deinem Unternehmen willst Du mit dieser Frage lösen? Und welche Bereiche Deines Unternehmens musst du mit einbeziehen? Stell Dir vor, die Anzahl der Verkäufe von T-Shirts in Deinem Onlineshop stagniert. Du suchst einen Weg diese zu steigern.

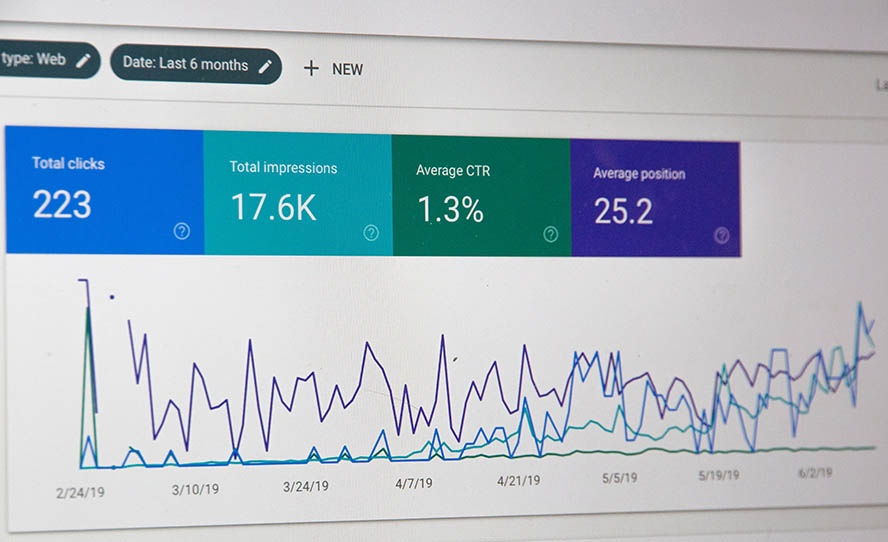

Die aktuelle Werbekampagne mittels Facebook Ads liefert gute Ergebnisse und Deine Kennzahlen sind auf den ersten Blick ok. Es klicken genügend Interessenten auf Deine Werbung und kommen auf die Landingpage mit den T-Shirts. Du bist Dir also unschlüssig, woran es liegen könnte.

Du stellst eine neue Hypothese auf: Die Conversion Rate der Landingpage lässt sich steigern, wenn Bewertungen von Kunden angezeigt werden. Dadurch werden mehr T-Shirts verkauft.

Jetzt gilt es diese Hypothese zu verifizieren. Das machst Du am einfachsten, indem Du Daten über das Verhalten Deiner Kunden auf der Website sammelst. Das Tool Hootjar (Beispiel) sammelt die Aktivitäten Deiner Kunden auf der Seite und aggregiert Dir die Ergebnisse und das Verhalten auf einer Heatmap. Diese Datenanalyse kann schon erste Indizien aufzeigen, wie Du Deine Seite optimieren kannst. Dann machst Du eine Optimierung und testest mit einem A/B-Test.

Auf Basis dieser Ergebnisse stellst Du die nächste Hypothese auf. Jeder Interpretation von Daten birgt gleichzeitig das Risiko einer Scheinkorrelation.

„Doch impliziert eine Korrelation noch nicht Kausalität, auch wenn der Zusammenhang kausal scheinen mag (Scheinkorrelation). Ohne kausalen Zusammenhang aber erfolgt eine Zuordnung von Ursache und Wirkung willkürlich ohne fundierte Begründung.”

Einfaches Beispiel: In verschiedenen europäischen Regionen wurde eine Korrelation zwischen der Zahl der Geburten und der Zahl der Storchenpaare festgestellt. Also mehr Geburten, wenn es mehr Storchenpaare gibt. Trotzdem gibt es hier keinen kausalen Zusammenhang. Die Korrelation entsteht durch die Tatsachen, dass in ländlichen Regionen mehr Störche nisten und auch tendenziell mehr Kinder pro Paar geboren werden.

Das zeigt, dass Du bei der Analyse vom Daten auf eine Pseudokausalität stoßen kannst. Aus diesem Grund ist die Verifikation Deiner Hypothesen unabdingbar. Ein A/B-Test hilft Dir dabei, eine Scheinkorrelation aufzudecken.

Datenquellen

Als Online-Marketer hast Du verschiedene Anwendungsgebiete für Big Data. Das geht von Cross-Selling-Angeboten über gezielte E-Mail-Kampagnen oder ganz klassische die „Abandoned Cart“-Mails. Der Fantasie sind hier keine Grenzen gesetzt. Der Ablauf ist hierbei immer gleich. Hypothese aufstellen, verifizieren, Anpassungen durchführen und von vorne.

Es wird der Punkt kommen, an dem Du eine gute Problemstellung und eine starke Hypothese hast, Dir allerdings die entsprechenden Datensätze für die Lösung fehlen. Durch die DSGVO und die Sensibilität der Kunden erhältst Du nicht mehr zwangsläufig alle relevanten Daten. Es gibt jedoch weiterhin mehrere Wege, um relevante Daten zu sammeln.

Besucherverhalten

Mittels Google Analytics analysierst Du das Verhalten der Besucher auf Deiner Website.

In Kombination mit einem CRM-System wie Hubspot kannst Du die Nutzungsdaten einem (schon bekannten) Kunden zuordnen.

Nehmen wir mal an, dass Dein Kunde sich in ein Kontaktformular von Dir einträgt oder schon einmal was bei Dir gekauft hat. Hubspot kann das erkennen und entsprechende die Aktivitäten genau diesem Kunden zuordnen. Hubspot ist hier jedoch nur ein Beispiel. Mit solchen Daten kannst Du noch besser auf den Kunden eingehen und eine gezielte E-Mail-Marketing-Kampagne starten.

Auch hier ist es wie immer wichtig: erst die Frage und dann das Sammeln von Daten. Gerade bei hohen Datenvolumen kann die Analyse aufwendig sein.

Daten von Suchmaschinen

Suchmaschinen wie Google und die Suchmaschinenoptimierung sind Tagesgeschäft. Die Daten, die Google sammelt, kannst Du auch für Deine Analysen nutzen. Durch Google Trends beispielsweise kannst Du Trendanalysen machen. Oder neue Geschäftsfelder erschließen. Der Fantasie sind auch hier keine Grenzen gesetzt. Die Informationen und Daten sind fast immer schon da. Die Frage ist, ob Du sie schon verwendest.

Umfragen

Umfragen sind eine starke und einfache Möglichkeit Daten zu erfassen. Sei es die Bewertung eines Servicemitarbeiters, damit Du Deinen Service optimieren kannst oder die Produktumfrage, damit Du Dein Produkt verbessern kannst. „Wie sehr würden Sie … weiterempfehlen.“ Daraus kann viel abgeleitet werden.

(Quelle: unsplash.com)

Klassische Marketing Use Cases

Im Folgenden möchte ich klassische Use Cases für Online-Marketer aufzeigen. Mit diesen kannst Du vermutlich schnell Mehrwert aus Big Data und Data Analytics ziehen.

Customer Value Analytics

Das Kundenmanagement gehört zum Herz eines Unternehmens. Es ist der zentrale Sammelpunkt für alle Informationen rund um den Kunden und hilft Dir die Beziehung zu Deinem Kunden zu pflegen. Software wie Hubspot und Co. lohnen sich schon, wenn Du mehr als 10 Kunden pro Jahr hast.

Je mehr Informationen Du über Deine Kunden erfassen kannst, je einfacher kannst Du am Ende auch bewerten, wie viel ein Kunde für Dich wert ist. Also klassische Kundenwertanalyse.

Hier geht es häufig neben den blanken Zahlen auch um die subjektive Wahrnehmung. Wenn einer Deiner Kunden am Telefon immer unfreundlich zu Deinen Mitarbeitenden ist, dann willst Du das auch in die Bewertung mit einbeziehen können. Diese Informationen müssen also auch in Dein System einfließen.

Gleichzeitig wirst Du durch ein gutes Kundenmanagement auch Deine Kunden Bindung stärken, denn Du kennst ihn besser als jeder andere Deiner Mitbewerber. Die Qualität der Datensätze ist wichtig. Also das richtige speichern und nicht einfach nur Masse.

Kundenbeziehungen stärken durch individuelles Angebot

Das kannst Du wiederum nutzen, um personalisierte Werbung für Deinen Kunden zu erstellen. Am einfachsten passiert das automatisch, aber schon eine nette E-Mail zu eurem letzten Kontakt mit der Frage: „Hat sich Dein Problem gelöst?“, wird Deinen Kunden freuen. Und wenn sich ein Kunde gut aufgehoben fühlt, dann wird er auf jeden Fall wieder bei Dir kaufen. Die Technologie kann Dich in diesem Bereich sehr gut unterstützen.

Natürlich kannst Du auch auf Basis von Deinen Daten entscheiden, wann Du welchen Kunden mal wieder kontaktieren solltest. Der Möglichkeiten sind keine Grenzen gesetzt. Vermutlich fallen Dir, während dem Lesen noch 1000 andere Möglichkeiten ein, wie Du durch Deine Daten Deine Kundenbeziehung stärken kannst.

Optimierung Deiner Preise

Wenn Du Daten über Deine Produkte und Verkäufe sammelst, dann kannst Du auch Analysen darüber machen, wie viel der Kunde typischerweise bereit ist zu bezahlen. In einem E-Commerce Shop könntest Du dann per A/B-Test prüfen, ob Du nicht sogar einen höheren Preis setzen kannst. Und daraus kannst Du ablesen, wie die Kunden sich verhalten. Dafür braucht es auf jeden Fall einen Referenzwert, dagegen kannst Du dann vergleichen.

Welche Daten sammle ich jetzt am besten?

Du siehst, dass Du aus Deinen Daten sehr viel herausholen kannst. Vielleicht kannst Du aus Deinen alten Daten auch Trends ableiten und daraus für die Zukunft bessere Angebote schnüren. In meinen Augen ist es jedoch einfacher, wenn Du nur Daten sammelst, aus denen Du auch etwas herausholen kannst. Qualität statt Quantität.

Es ist selten der Fall, dass Du aus alten Daten, die Du speicherst, weil Du sie eben speicherst, wirklich noch einen Mehrwert ziehen kannst. Die Welt verändert sich und so auch die Informationen, die Du aus den Daten ziehen willst, bzw. kannst. In Zeiten, in denen Datenverarbeitung in Echtzeit eine wichtige Rolle spielt, sind veraltete Daten meist nicht zu gebrauchen.

Zusätzlich stellt sich die Frage in welcher Datenbank Du diese Daten speicherst. Nutzt Du Cloud Services oder benötigst Du eigene Datenbanken. Dann stellt sich auch die Fragen, ob du Technologien wie Hadoop oder Mapreduce nutzen musst. Das sind optimierte Datenbanksysteme für Verarbeitung von Big Data Massendaten.

Wenn Du nicht in einem Konzern arbeitest, dann geht die Empfehlung auf jeden Fall Richtung Cloud Anwendungen. Die bringen Lösungen Big Data schon häufig mit und haben gute Prozesse zur Datenspeicherung. Das ist auch die Grundlage für schnelle Abfragen und schnelle Datenverarbeitung.

Sei flexibel und sammle keine unnötigen Daten. Das ist eine gute Richtlinie, aber am Ende kannst nur Du bewerten, was gute oder schlechte Daten sind. Einen guten Prozess dafür aufzusetzen ist der Schlüssel. Überlege Dir genau, welche Anwendung oder welches System Du verwenden möchtest. Daraus kannst Du für Dein Unternehmen ableiten, wie die Daten verarbeitet werden sollen.

Es gibt nicht die eine Lösung oder das eine System, die Du brauchst. Es ist meistens eine Kombination aus mehreren Anwendungen, die dann auf die Verarbeitung von Daten spezialisiert sind. Beispiele dafür haben wir oben schon ein paar genannt. Google Analytics ist die perfekte Technologie, um die Bewegung Deiner Nutzer auf Deiner Webseite zu erfassen. Was jedoch nicht für jedes Unternehmen die perfekte Anwendung sein muss. Manchmal sind die Anforderungen zu individuell und die Entwicklung eines eigenen Tools ist unabdingbar.

Wann Du Dir über Big Data keine Gedanken machen solltest

Ich habe letztes Jahr in einem der größten Energiekonzerne Deutschlands ein Software Projekt begleitet, wo es um Big Data ging. Das Projekt sollte Daten von Strom, Gas und Börsengeschäften sammeln und auswerten. Und das waren mehrere Tausend die Minute. Am Ende war das Ziel im Projekt klar und es gab einen fachlichen Nutzen, der aus den Daten gezogen werden soll. Dadurch sollten die Händler bessere Entscheidungen treffen können, ob und wann gekauft bzw. verkauft werden soll. Das ganze voll automatisiert, denn händisch kannst Du diese Masse an Datensätze nicht auswerten und zusätzlich wärst Du für Börsengeschäfte noch viel zu langsam. Datenverarbeitung musste hier in Echtzeit passieren. Je schneller, desto besser.

Das Beispiel ist ein klassischer Use Case für Big Data. Findest Du Dich darin wieder?

Hast Du das Gefühl, dass Du Big Data machen musst, weil es ein neuer Trend ist? Läuft bei Dir alles wunderbar und Du hast gar kein Problem, welches Du mit Big Data lösen könntest? Oder Du hast in den letzten Absätzen gemerkt, dass Du schon längst Big Data oder Data Analytics nutzt?

Dann darfst Du Dich entspannt zurücklehnen. Mach Dir einen Kaffee und stürze Dich auf Deine aktuellen Herausforderungen. Wenn Du mal den Gedanken haben solltest: „In diesem Fall könnte ich wirklich mit mehr Datenanalyse zu einem besseren Ergebnis kommen.“ Dann Feuer frei und ran an den Speck.

Doch egal, ob wir jetzt von Big Data, Large Data oder ein paar Daten sprechen. Data Analytics soll Dir am Ende Mehrwert aus den vorhandenen Daten bringen und das muss gut umgesetzt werden. Denn am Ende kannst Du Dich in den Daten auch verlieren und im schlimmsten Falle werden sie noch falsch interpretiert.

Diesen Artikel jetzt als Video anschauen

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenZusammenfassung – was kannst Du konkret tun?

Gehen wir mal davon aus, dass Du einen Use Case für Big Data und Data Analytics hast und Du aus einer Masse von Daten gerne bestimmte Informationen ziehen möchtest. Am besten noch automatisiert.

Ich würde in jedem Fall folgendermaßen vorgehen:

- Definiere, wo Deine Daten herkommen sollen

- Wie kannst du an die Daten komme? (Liegen die beispielsweise auf einer Datenbank oder in einer Anwendung?)

- Definiere, welche Informationen Du aus den Daten gewinnen willst

- Überlege Dir, wie Du die Daten so interpretieren kannst, damit Du Deine Information herausfinden kannst. (Das ist einer der wichtigsten Punkte, denn vielleicht fällt Dir hier schon auf, dass Du ganz andere Daten benötigst)

- Die ersten drei Punkte sind Deine Hypothese, jetzt geht es in die Umsetzung

- Umsetzung eines Prototyps (bei sehr speziellen Anforderungen wirst Du an individueller Entwicklung nicht vorbeikommen. Die Programmiersprache Python ist dafür aktuell zu empfehlen)

- Iterative Weiterentwicklung auf Basis der Erfahrungen, die Du mit dem Prototyp gemacht hast

Konkreter in das Thema einzusteigen ist schwer, denn die Use Cases könnten vermutlich unterschiedlicher nicht sein. Du darfst mich jedoch gerne jederzeit auf LinkedIn kontaktieren und ich bin bereit das Thema mit Dir zu diskutieren oder kontaktiere mich über meine Website.

Gerne erweitere ich diesen Artikel dann noch mal.

Wenn Du Dir eines merken solltest, dann das:

Nutze das Prinzip der agilen Softwareentwicklung. Bauen, messen, lernen. Fang mit einem Prototyp an und verifiziere Deine Hypothese. Dann wirst Du nach vorne kommen, kein Geld verbrennen und Dir Mehrwert aus Big Data ziehen können.

Weitere Artikel, Webinare und Podcasts zum Thema Webanalyse findest Du in unserer Themenwelt:

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen